Un affichage True Tone pour les Apple Glass ?

Alban Martin

Alban Martin- Il y a 5 ans

- 💬 Réagir

- 🔈 Écouter

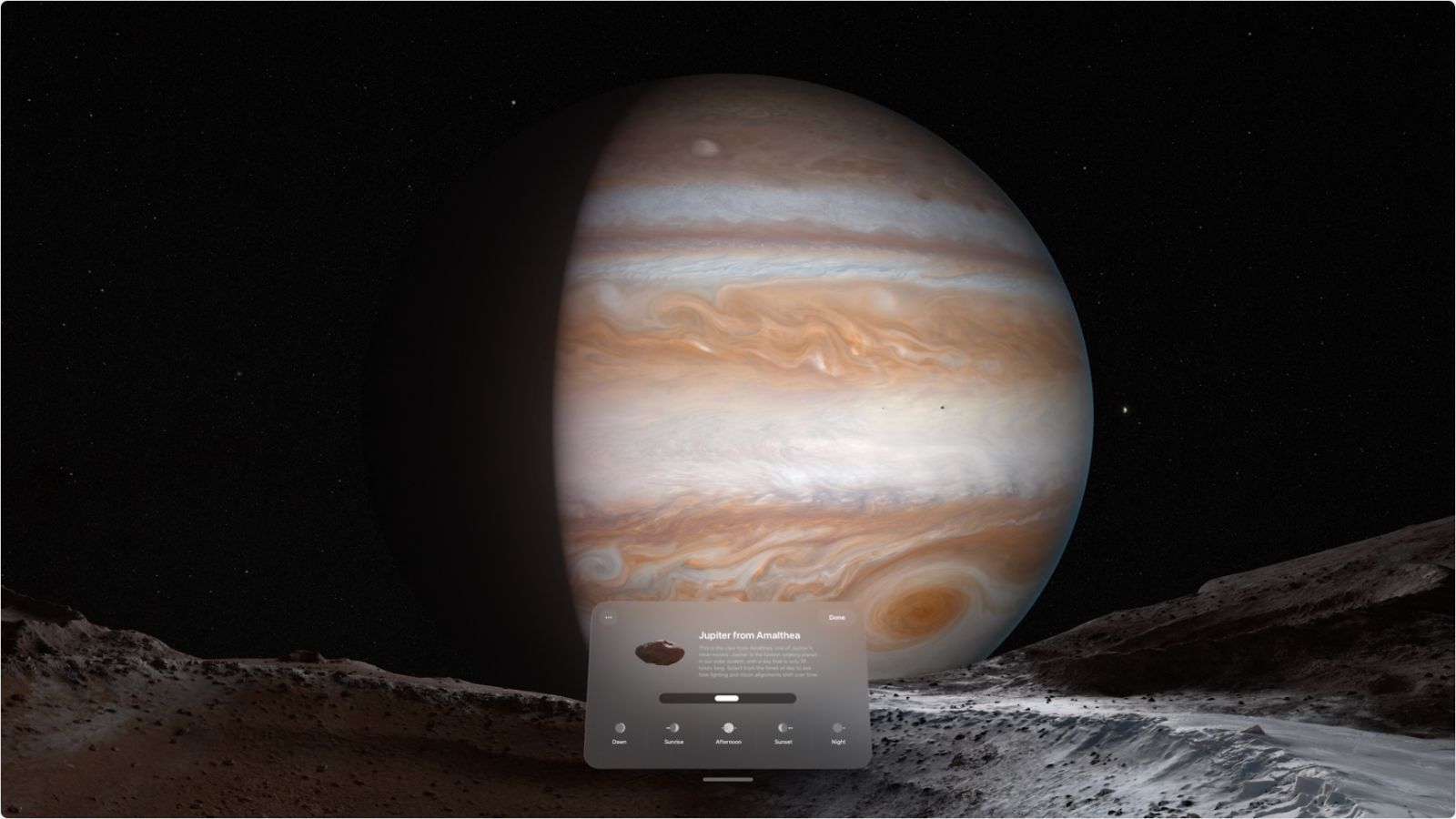

![]() Pour donner l'impression que les objets virtuels s'intègrent dans l'environnement réel, les futures Apple Glass pourraient ajuster les éléments AR en fonction de la lumière et d'autres facteurs contextuels.

Pour donner l'impression que les objets virtuels s'intègrent dans l'environnement réel, les futures Apple Glass pourraient ajuster les éléments AR en fonction de la lumière et d'autres facteurs contextuels.

Alors que les présentateurs télé savent que certains vêtements provoquent des interférences, Apple a identifié des problèmes similaires pour la réalité augmentée, et les dernières nouvelles recherches AR montrent qu'elle travaille pour contrer les problèmes.

Un problème d'affichage en AR selon la lumière

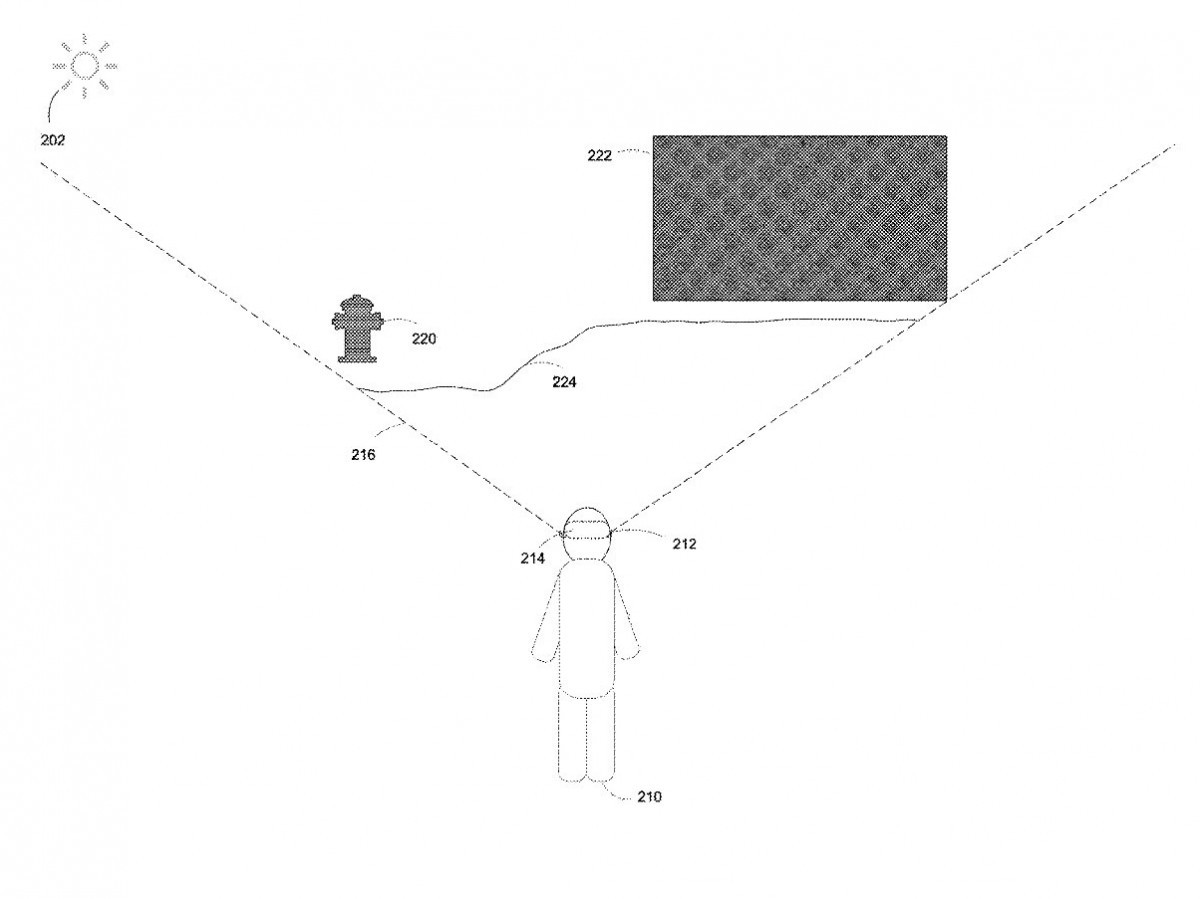

«Modification des paramètres de fonctionnement de l'affichage en fonction de la superposition de la lumière à partir d'un environnement physique» est une demande de brevet récemment révélée qui s'intéresse particulièrement à la façon dont l'éclairage peut causer des problèmes avec différents objets virtuels.

Dans la réalité augmentée (AR), le contenu généré par ordinateur est composé avec l'environnement physique d'un utilisateur afin de combiner le contenu visuel généré par ordinateur avec des objets du monde réel. Un utilisateur peut faire l'expérience d'un contenu AR en portant un dispositif de montage sur tête (HMD) qui comprend un écran translucide ou transparent, qui, à son tour, permet le passage de la lumière de l'environnement physique de l'utilisateur aux yeux de l'utilisateur.

Apple décrit l'accessoire monté sur la tête (HMD) comme étant «un affichage additif», ce qui signifie qu'il ajoute «un contenu généré par ordinateur à la lumière de l'environnement physique de l'utilisateur».

Apple poursuit son explication du problème :

Dans certaines circonstances, la lumière de l'environnement physique a une composition de couleur et / ou une luminosité qui interfère avec le contenu généré par ordinateur d'une manière qui dégrade l'expérience AR. Par exemple, la lumière de l'environnement physique limite un niveau de contraste entre l'environnement physique et le contenu généré par ordinateur affiché.

Apple n'est pas le premier à repérer le problème, mais la demande de brevet rejette les tentatives précédentes de le résoudre avec des techniques «similaires aux lunettes de soleil».

Certains systèmes précédemment disponibles incluent une couche de gradation fixe physique qui est intégrée à un écran translucide et à l'environnement physique. Cependant, l'écran affiche une version constamment plus sombre de l'environnement physique de l'utilisateur, dégradant ainsi l'expérience de l'utilisateur et empêchant l'utilisation de tels systèmes dans des situations de faible éclairage.

Par conséquent, la proposition d'Apple est plus granulaire que d'abaisser une nuance sur tout. Au lieu de cela, les lunettes AR, ou un dispositif similaire, rechercheraient en permanence «une pluralité de valeurs caractéristiques de superposition de lumière» lorsque celle-ci interfère avec les objets AR.

En détectant les niveaux de lumière ambiante et en détectant la composition des objets dans le champ de vision de l'utilisateur, le système connaît déjà les «caractéristiques d'affichage prédéterminées d'un objet de réalité générée par ordinateur (CGR)».

Par conséquent, le système peut alors ajuster "un ou plusieurs paramètres de fonctionnement d'affichage" du dispositif, "afin de satisfaire les caractéristiques d'affichage prédéterminées de l'objet CGR dans un seuil de performance".

Déterminer où regarde un utilisateur

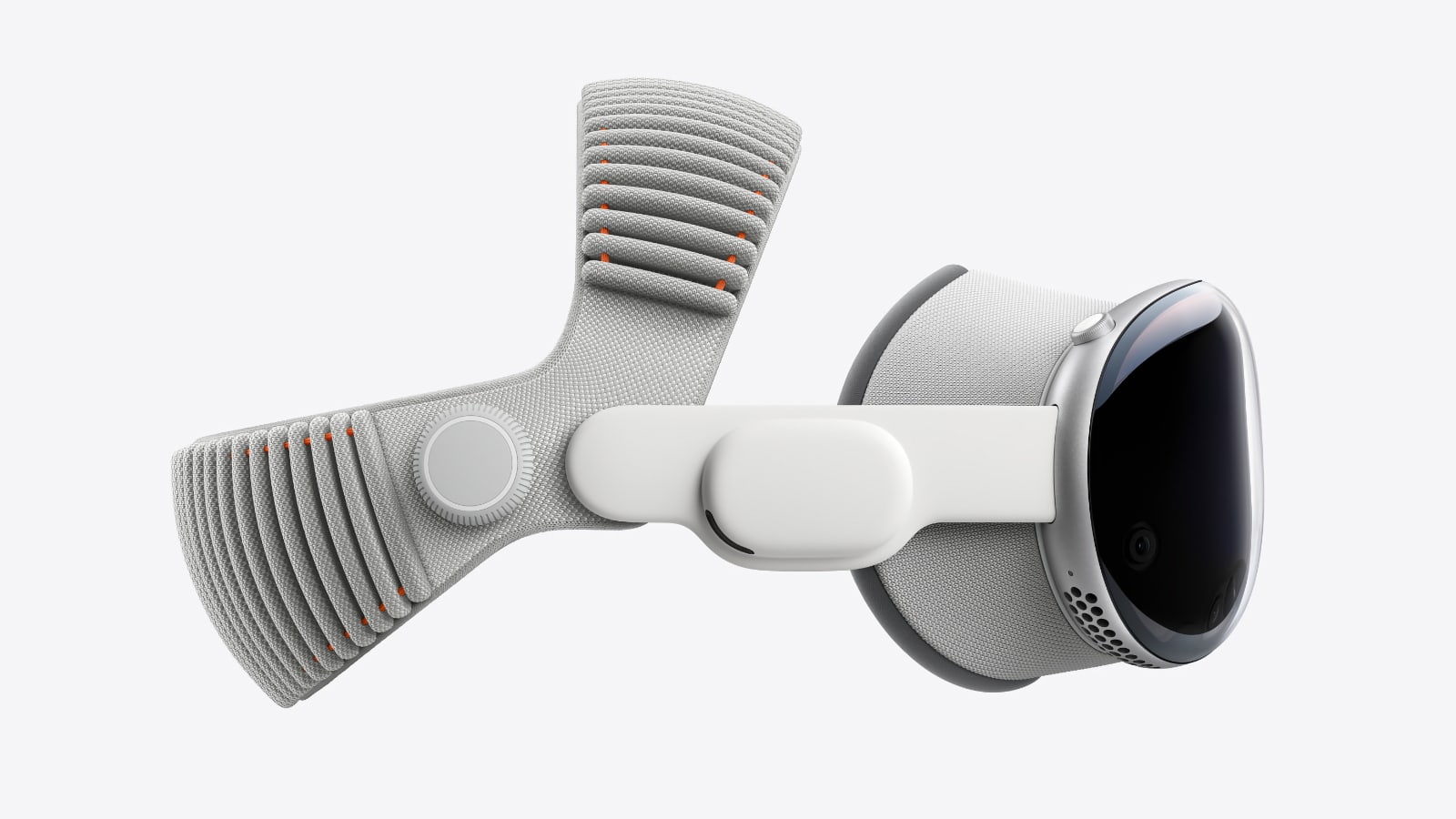

Les Apple Glass, comme tout autre appareil AR, doit équilibrer les performances et les fonctionnalités avec la durée de vie de la batterie. Apple a travaillé à plusieurs reprises pour maximiser cet équilibre en se concentrant uniquement sur ce que le porteur regarde à l'instant "t".

L'obligation de modifier les objets AR d'un HMD pour éviter des problèmes avec l'environnement est pratiquement annulée si le porteur regarde actuellement autre chose. Ainsi, parallèlement à ses nombreux brevets antérieurs de détection du regard, un deuxième brevet récemment révélé concerne ce que les gens regardent - et comment cet objet peut alors réagir.

«Débogage et inspection basés sur la mise au point pour un système d'affichage», détermine «un point de mise au point par rapport à un emplacement de visualisation dans un environnement virtuel», en utilisant la «profondeur de mise au point des yeux».

Les écrans dépendant de la direction du regard sont utilisés dans les systèmes de réalité générés par ordinateur, tels que les systèmes de réalité virtuelle, les systèmes de réalité augmentée et les systèmes de réalité mixte. De tels environnements peuvent inclure de nombreux objets, chacun avec ses propres propriétés, paramètres, fonctionnalités et / ou autres caractéristiques.

Ainsi, selon l'endroit où l'utilisateur regarde et ce que sont à la fois la réalité augmentée et les environnements du monde réel, il peut y avoir de nombreux objets virtuels à voir et à manipuler. En utilisant les méthodes décrites dans cette demande de brevet, le système AR peut également calculer quand un objet virtuel en obscurcit un autre.

Si l'ajustement des objets pour correspondre à la lumière ambiante est comme True Tone, cette demande de brevet rappelle comment le Mac dessinait à l'origine les fenêtres. À l'origine, macOS économisait les ressources de traitement en ne redessinant et en n'actualisant pas toute une fenêtre lorsqu'une partie de celle-ci était couverte par une autre.

La demande de brevet de type True Tone est attribuée à Anselm Grundhoefer et Michael J. Rockwell.

Des quatre inventeurs crédités sur la demande de brevet de profondeur de focalisation oculaire, Norman N. Wang et Tyler L. Casella ont déjà travaillé sur la façon dont les objets AR pourraient être partagés et modifiés.