FastVLM : l'IA ultra-rapide qui animera les futures lunettes connectées Apple

Nadim Lefebvre

Nadim Lefebvre- Il y a 10 mois

- 💬 2 coms

- 🔈 Écouter

![]() Apple vient de dévoiler FastVLM, un modèle de langage visuel (VLM) qui pourrait bien être au cœur de ses futurs appareils connectés, notamment les lunettes intelligentes dont le lancement est prévu pour 2027. Ce modèle d'IA représente une avancée significative dans le traitement d'images à haute résolution, avec des performances qui laissent entrevoir de nouvelles possibilités pour les wearables d'Apple.

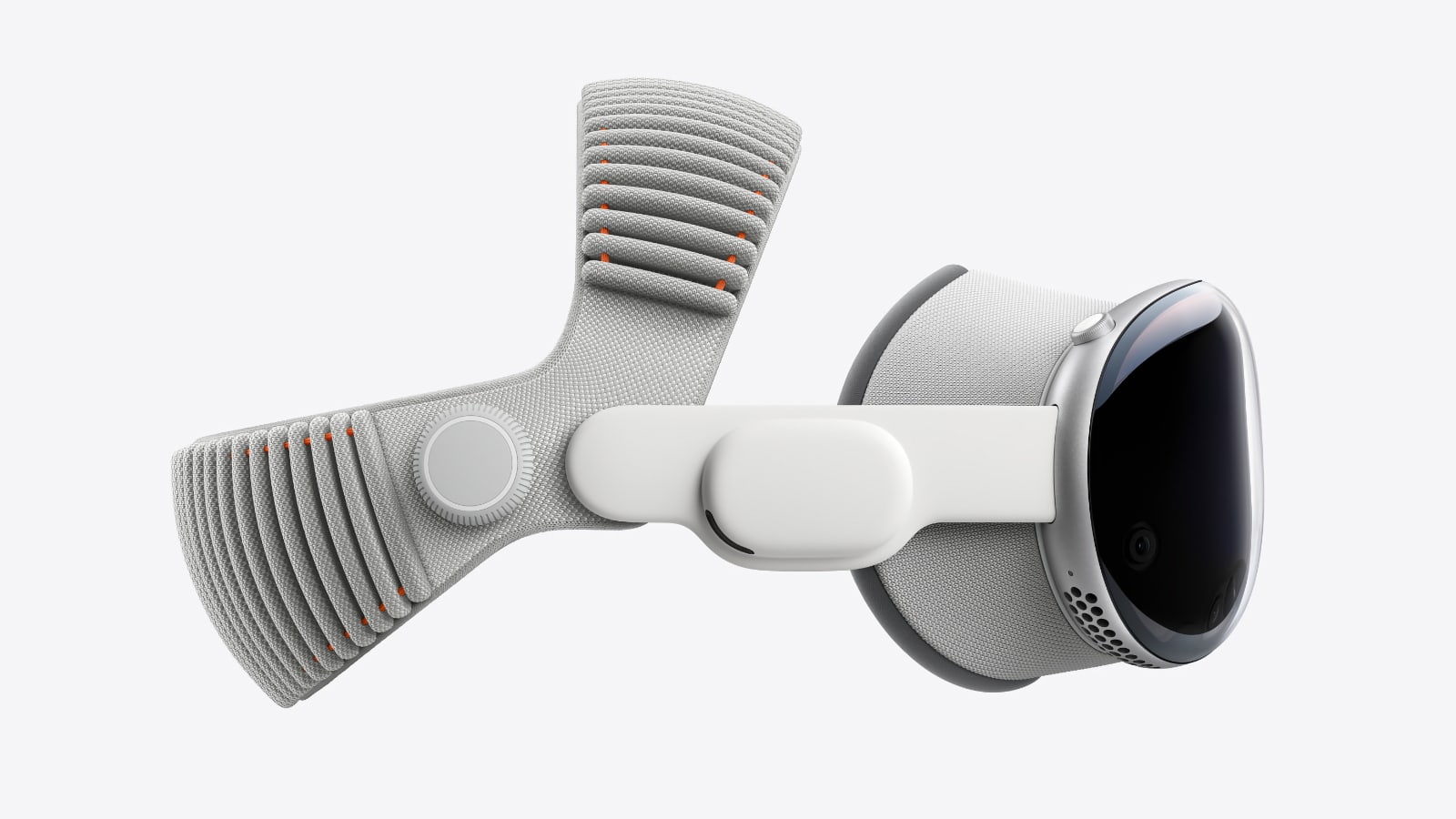

Apple vient de dévoiler FastVLM, un modèle de langage visuel (VLM) qui pourrait bien être au cœur de ses futurs appareils connectés, notamment les lunettes intelligentes dont le lancement est prévu pour 2027. Ce modèle d'IA représente une avancée significative dans le traitement d'images à haute résolution, avec des performances qui laissent entrevoir de nouvelles possibilités pour les wearables d'Apple.

Une vitesse d'exécution sans précédent

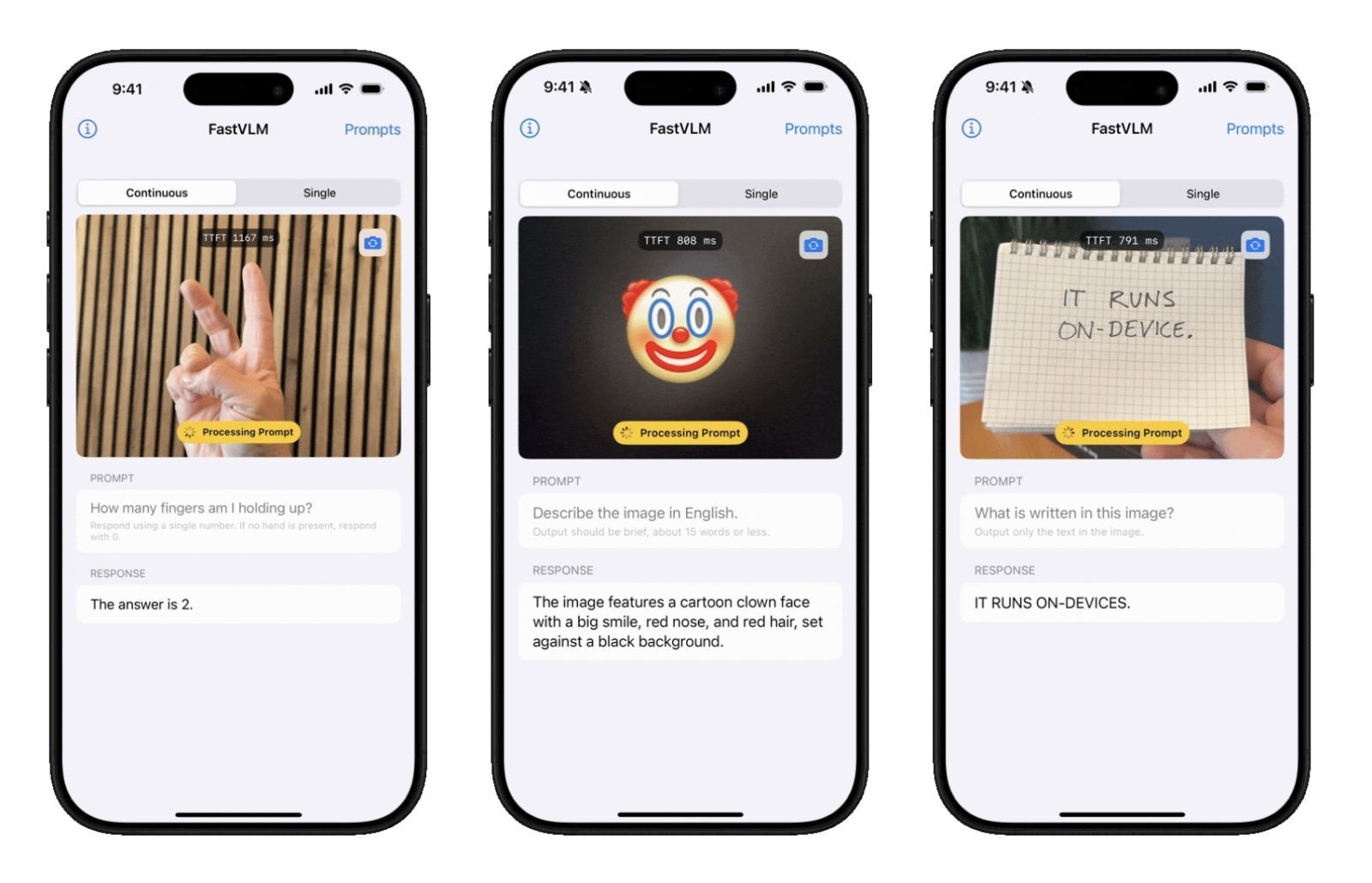

FastVLM se distingue par sa rapidité exceptionnelle. Selon Apple, ce modèle est capable de générer le premier token de réponse 85 fois plus rapidement que les modèles concurrents comme LLaVA-OneVision. Cette performance est rendue possible grâce à son encodeur visuel FastViTHD, spécifiquement conçu pour traiter efficacement les images haute résolution.

Cet encodeur est non seulement 3,2 fois plus rapide que les solutions existantes, mais également 3,6 fois plus compact, ce qui en fait un candidat idéal pour une intégration dans des appareils aux ressources limitées comme des lunettes connectées. La réduction significative du nombre de tokens générés permet au modèle de traiter l'information visuelle beaucoup plus efficacement, tout en maintenant une précision comparable aux modèles plus volumineux.

Des applications idéales pour les lunettes connectées

Les caractéristiques de FastVLM correspondent parfaitement aux besoins des lunettes intelligentes qu'Apple développe actuellement. Ce modèle permettrait aux futures Apple Glasses de traiter localement les informations visuelles capturées par leurs caméras, sans avoir à dépendre du cloud. Cette approche garantirait non seulement une réactivité immédiate mais aussi une meilleure protection de la vie privée des utilisateurs.

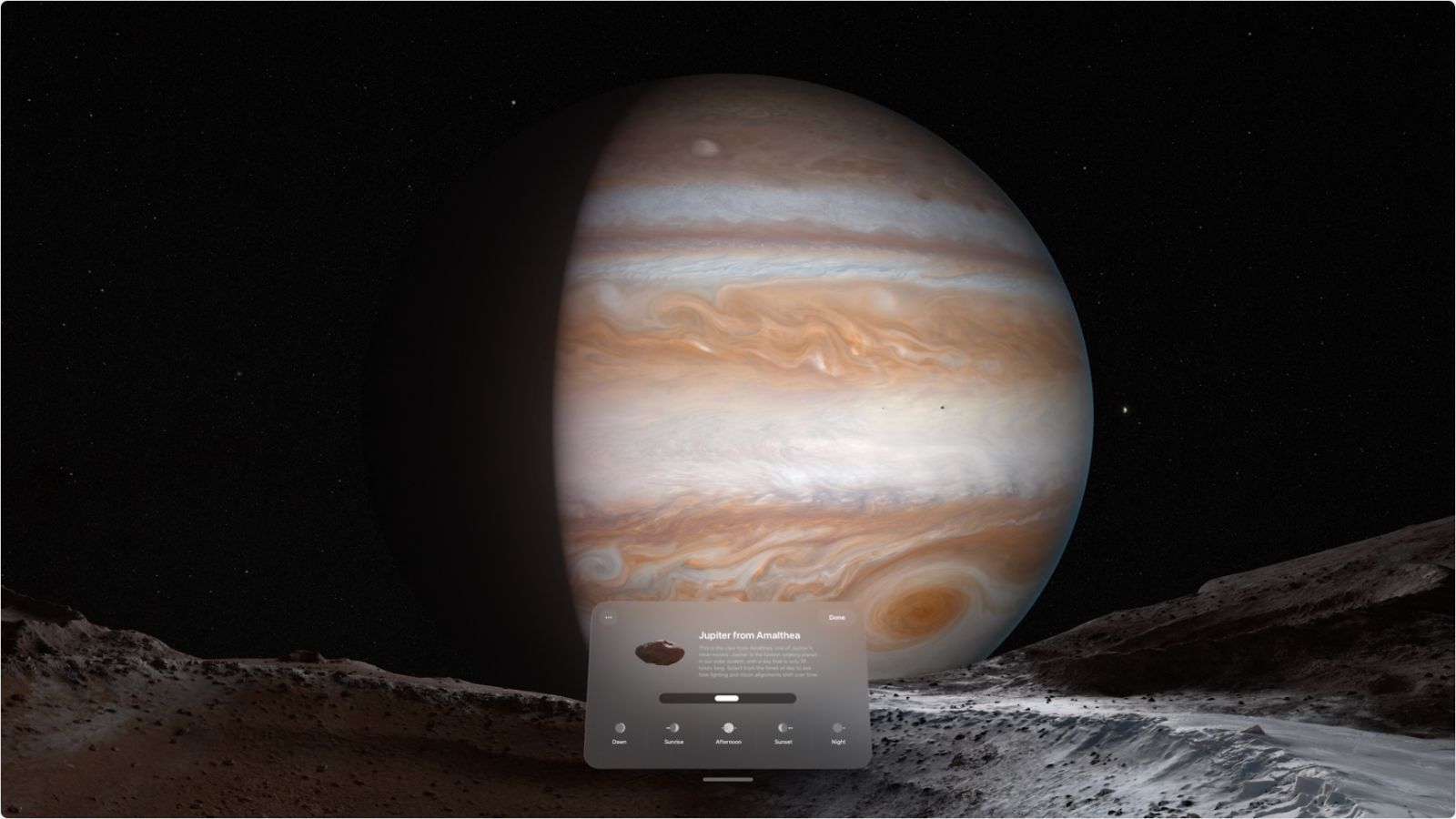

FastVLM pourrait ainsi permettre aux lunettes d'Apple d'identifier instantanément des objets, de lire du texte manuscrit, de reconnaître des émojis ou encore d'analyser des gestes comme le nombre de doigts levés par l'utilisateur. Ces capacités seraient essentielles pour offrir une expérience d'informatique spatiale fluide et intuitive, similaire à celle du Vision Pro mais dans un format beaucoup plus compact et portable.

Le modèle s'appuie sur MLX, le framework d'apprentissage automatique open source d'Apple spécialement conçu pour Apple Silicon. Cette intégration optimisée permettrait d'exploiter pleinement les futures puces qui équiperont les lunettes connectées d'Apple, tout en minimisant la consommation d'énergie - un facteur critique pour ce type d'appareil.

- Tous les détails du projets FastVLM d'Apple sont disponibles sur Github