Apple Intelligence est bridée par des prompts pour ne pas halluciner

Nadim Lefebvre

Nadim Lefebvre- Il y a 1 an

- 💬 Réagir

- 🔈 Écouter

![]() Avec le lancement des nouvelles bêtas pour développeurs la semaine dernière, on a pu avoir un premier aperçu des fonctionnalités d'IA générative qu'Apple prévoit de déployer sur iPhone, iPad et Mac dans les prochains mois. Mais sur Mac, il est même possible d'accéder aux instructions codées dans les modèles qui alimentent certaines fonctions d'Apple Intelligence, comme l'a découvert un utilisateur de Reddit.

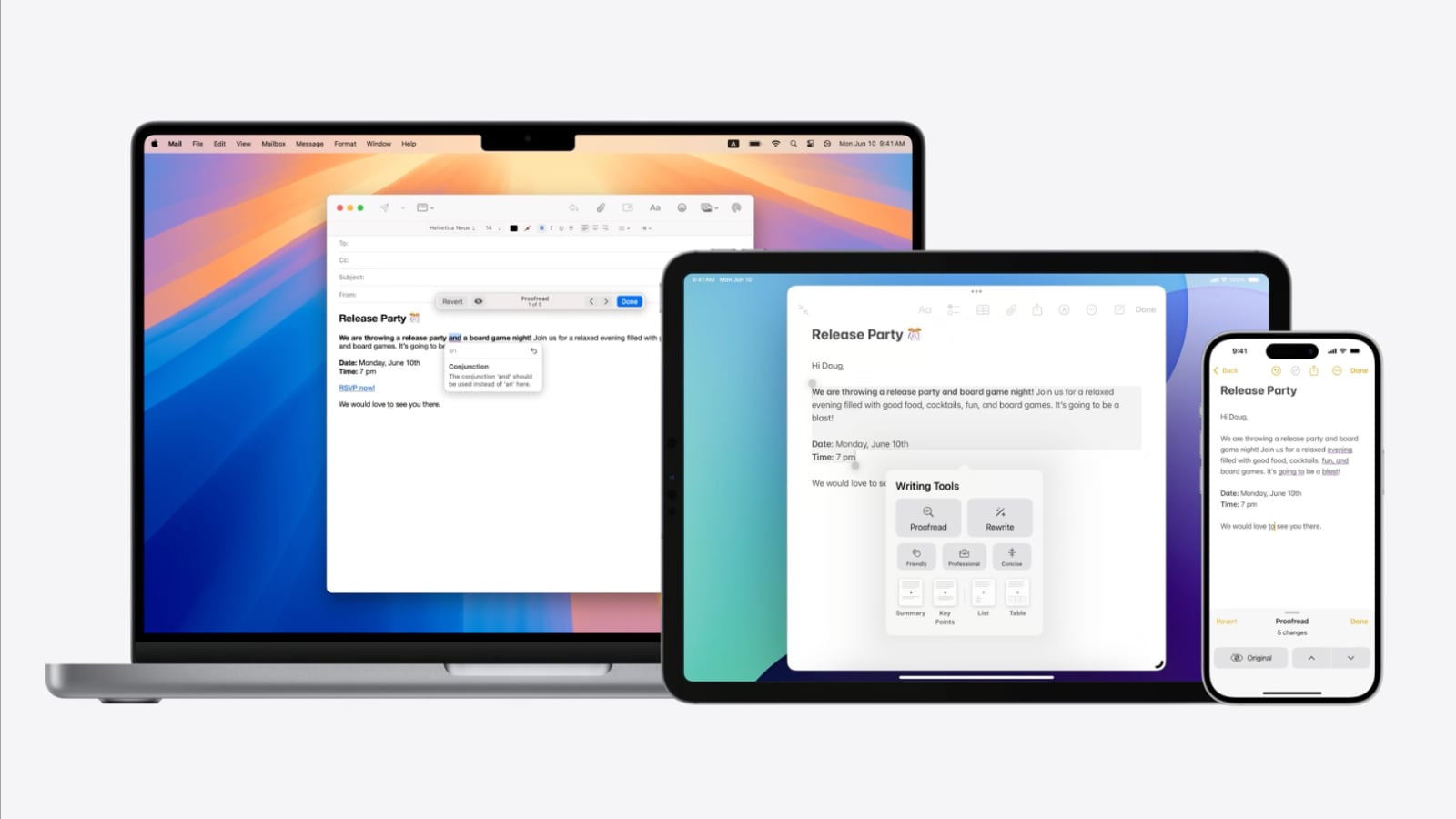

Avec le lancement des nouvelles bêtas pour développeurs la semaine dernière, on a pu avoir un premier aperçu des fonctionnalités d'IA générative qu'Apple prévoit de déployer sur iPhone, iPad et Mac dans les prochains mois. Mais sur Mac, il est même possible d'accéder aux instructions codées dans les modèles qui alimentent certaines fonctions d'Apple Intelligence, comme l'a découvert un utilisateur de Reddit.

Des prompts pour cadrer les réponses de l'IA

Ces instructions apparaissent sous forme de prompts, c'est-à-dire de consignes passées par défaut à l'agent conversationnel avant même que l'utilisateur ne lui soumette une requête. C'est une pratique courante pour les outils d'IA comme ChatGPT ou DALL-E, dont les prompts cachés avaient déjà fuité. Rien de surprenant donc, les pré-prompts sont un moyen parmi d'autres de cadrer un modèle de langage pour qu'il ne génère pas n'importe quoi.

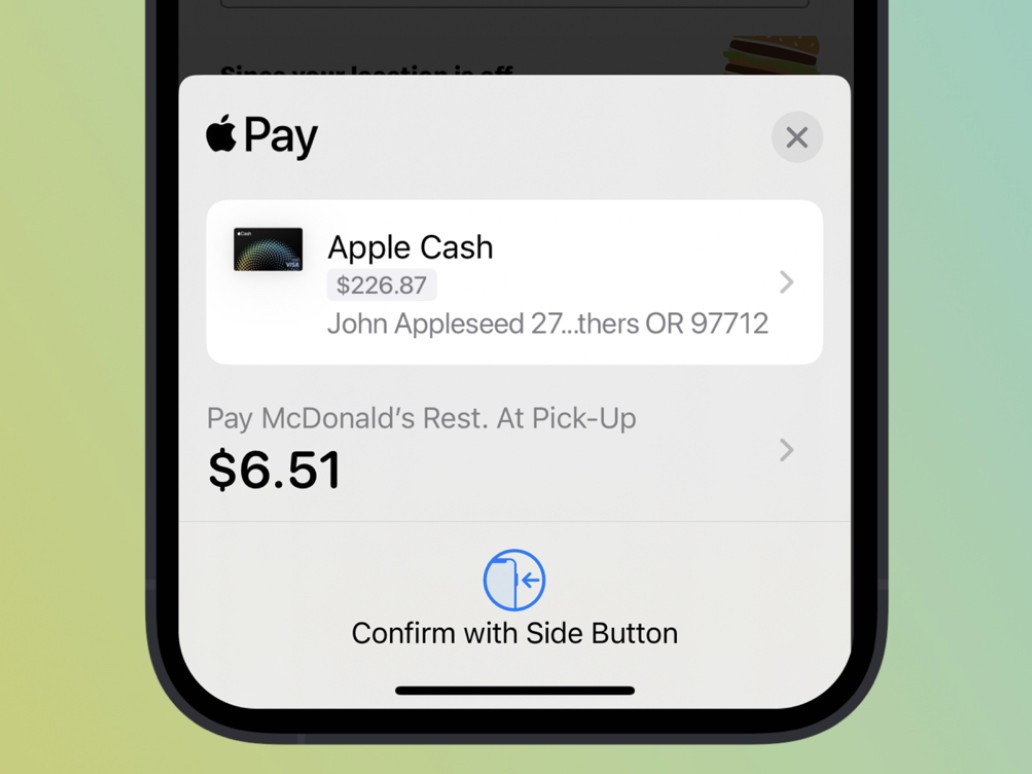

Dans les fichiers de la bêta de macOS 15.1, on peut ainsi lire les prompts destinés à un "assistant mail utile". Il lui est demandé de poser des questions pertinentes en fonction du contenu de l'e-mail, puis de suggérer des réponses possibles, sans doute dans le cadre de la fonctionnalité Smart Reply. D'autres instructions concernent l'outil de Réécriture, accessible en surlignant du texte. L'IA doit alors reformuler en moins de 50 mots, avec la consigne explicite de "ne pas halluciner" et de "ne pas inventer d'informations factuelles".

On trouve aussi des prompts pour résumer des e-mails en 3 phrases de moins de 60 mots, ou encore pour générer une histoire à partir de photos, probablement pour la fonction Souvenirs de l'app Photos. Il est alors précisé d'éviter les thèmes "religieux, politiques, négatifs, tristes ou provocateurs".

Apple peut-elle vraiment empêcher son IA d'halluciner ?

Ces prompts nous donnent un aperçu de la façon dont Apple tente d'encadrer ses outils d'IA pour éviter les dérapages. La consigne de ne pas halluciner, c'est-à-dire de ne pas générer d'informations factuelles fausses, revient régulièrement.

Mais est-ce réellement possible ? Le problème des IA génératives est justement qu'elles n'ont pas de réelle compréhension des contenus et peinent donc à distinguer le vrai du faux dans ce qu'elles produisent. Apple a bien conscience que les résultats de son IA seront scrutés de près. Inclure ce type de prompts est sans doute une façon de montrer qu'elle prend le problème au sérieux, même si cela ne garantit pas à 100% des réponses fiables.

Les modèles d'Apple Intelligence, qui portent le nom de code interne ajax, seront en tout cas observés de près lors de leur déploiement auprès du grand public dans les prochains mois. Ces prompts cachés nous donnent un premier aperçu de la façon dont Apple espère garder la main sur son IA.

Source