Apple détaille le scan des messages pour protéger les enfants

Medhi Naït Mazi

Medhi Naït Mazi- Il y a 5 ans

- 💬 8 coms

- 🔈 Écouter

![]() Apple a annoncé hier soir une série de nouvelles sécurités pour les enfants qui s'ajoutent aux dernières mises à jour d'iOS 15, iPadOS 15 et macOS Monterey et qui visent à assurer la sécurité des enfants en ligne. Alors que seules les photos envoyées sur iCloud sont analysées, du côté des messages, c’est un peu plus complexe.

Apple a annoncé hier soir une série de nouvelles sécurités pour les enfants qui s'ajoutent aux dernières mises à jour d'iOS 15, iPadOS 15 et macOS Monterey et qui visent à assurer la sécurité des enfants en ligne. Alors que seules les photos envoyées sur iCloud sont analysées, du côté des messages, c’est un peu plus complexe.

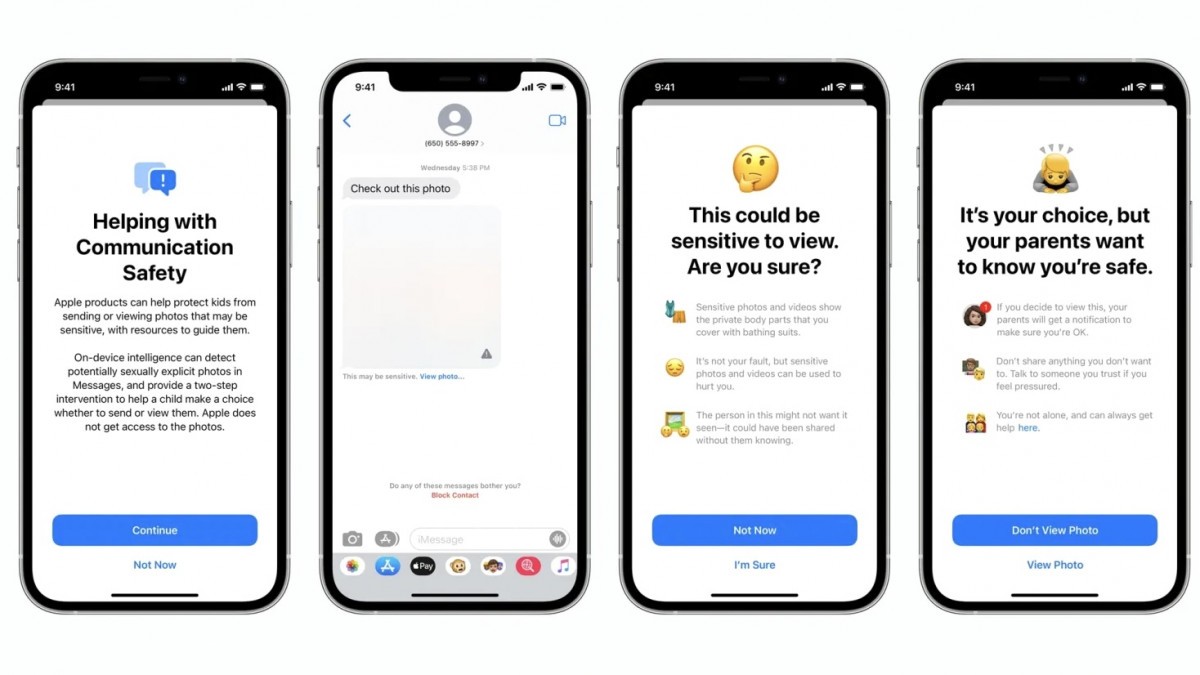

Comment fonctionne le système de vérification des photos sensibles

L'une des nouvelles fonctionnalités, Communication Safety - ou Sécurité des communications en français, a soulevé des préoccupations en matière de confidentialité car elle permet à Apple de numériser les images envoyées et reçues par l'application Messages à la recherche de contenu sexuellement explicite, mais Apple a confirmé qu'il s'agit d'une fonctionnalité d'adhésion limitée aux comptes des enfants et qu'elle doit être activée par les parents.

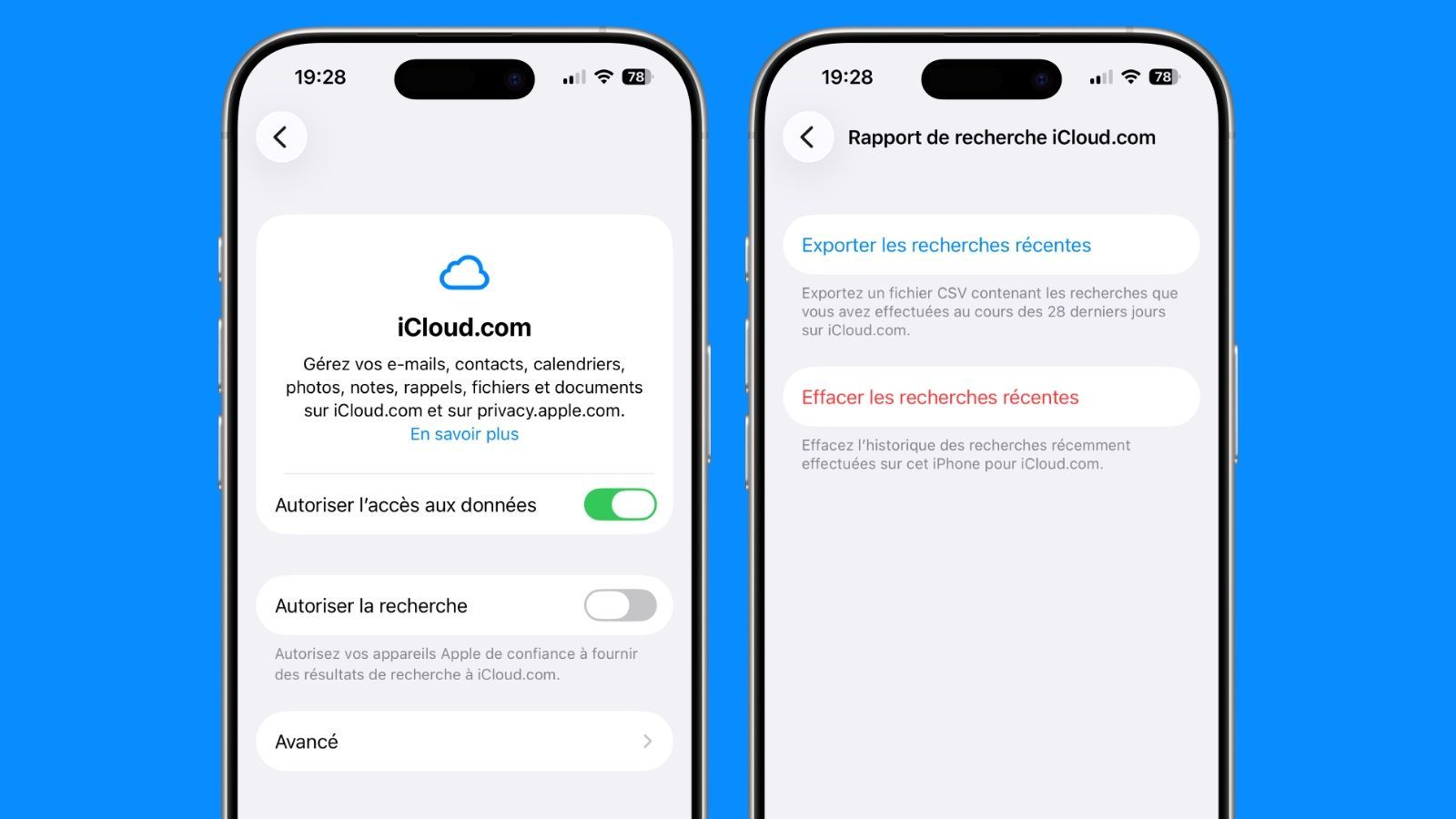

Si un parent active la sécurité des communications pour le compte d'un enfant, Apple analysera les images envoyées et reçues dans l'application Messages pour détecter la nudité. Si la nudité est détectée, la photo sera automatiquement floue et l'enfant sera averti que la photo peut contenir des parties privées du corps.

Des photos et des vidéos sensibles montrent les parties du corps privées que vous couvrez de maillots de bain. Ce n'est pas de votre faute, mais des photos et des vidéos sensibles peuvent être utilisées pour vous blesser.

L'enfant peut tout de même choisir de voir la photo en question, et pour les enfants de moins de 13 ans, les parents peuvent choisir de recevoir une notification si leur enfant clique dessus pour voir une photo floue. "Si vous décidez de voir cela, vos parents recevront une notification pour s'assurer que vous allez bien", peut-on lire dans l'écran d'avertissement.

Ces notifications parentales sont facultatives et ne sont disponibles que lorsque l'enfant qui regarde la photo a moins de 13 ans. Les parents ne peuvent pas être informés lorsqu'un enfant âgé de 13 à 17 ans voit une photo floue.

Communication Safety ne peut pas être activé sur les comptes adultes et n'est disponible que pour les utilisateurs de moins de 18 ans, de sorte que les adultes n'ont pas à se soucier de la numérisation de leur contenu pour détecter la nudité.

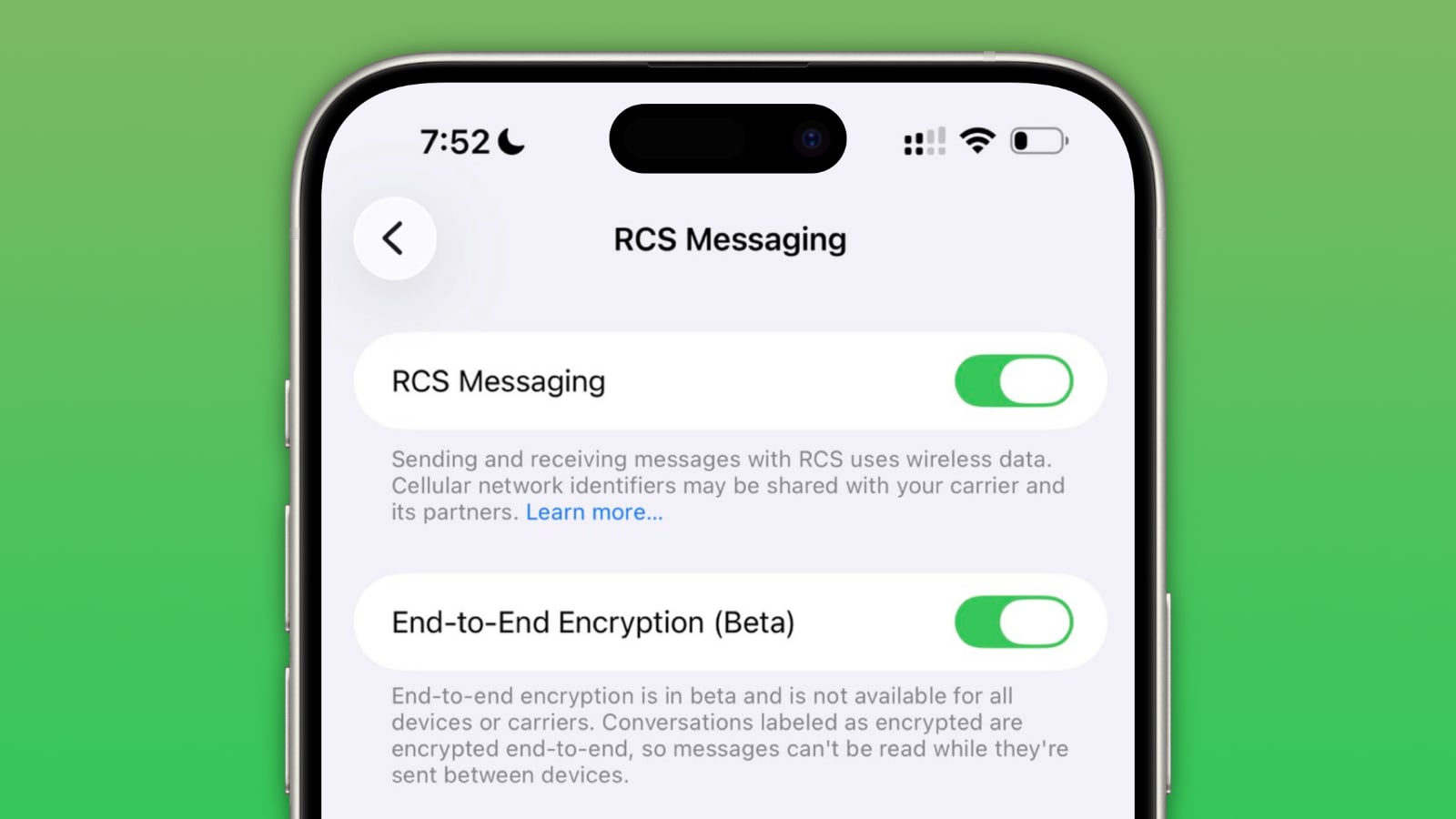

Enfin, pour le mettre en place, les parents doivent expressément s'inscrire à Communication Safety lors de la configuration de l'appareil d'un enfant avec partage familial. La fonctionnalité utilise l'apprentissage automatique sur l'appareil pour analyser les pièces jointes d'images et, parce qu'il est sur l'appareil, le contenu d'un iMessage n'est pas lisible par Apple et reste protégé par un cryptage de bout en bout.

Qui pense l’activer pour ses enfants ?

Apple veut protéger les enfants des photos sensibles dans iOS (màj : officiel)

Apple veut protéger les enfants des photos sensibles dans iOS (màj : officiel)