Apple veut protéger les enfants des photos sensibles dans iOS (màj : officiel)

Alban Martin

Alban Martin- Il y a 5 ans (Màj il y a 5 ans)

- 💬 9 coms

- 🔈 Écouter

Un expert en sécurité affirme qu'Apple est sur le point d'annoncer des outils de reconnaissance photo qui permettraient d'identifier les images de maltraitance d'enfants dans ses systèmes d'exploitation, iOS en tête. Après avoir intégré de nombreuses fonctionnalités basées sur le Machine Learning, la firme pourrait aller plus loin sur ce l'analyse.

Un expert en sécurité affirme qu'Apple est sur le point d'annoncer des outils de reconnaissance photo qui permettraient d'identifier les images de maltraitance d'enfants dans ses systèmes d'exploitation, iOS en tête. Après avoir intégré de nombreuses fonctionnalités basées sur le Machine Learning, la firme pourrait aller plus loin sur ce l'analyse.

Un outil puissant qui pourrait poser problème

Apple a précédemment supprimé des applications de l'App Store pour des raisons de prédo-pornographie, mais on dit maintenant qu'elle est sur le point d'introduire un tel système de détection à l'échelle du système. En utilisant le hachage de photos, les iPhones pourraient identifier les abus sexuel sur mineurs (CSAM) sur l'appareil.

Apple ne l'a pas confirmé et jusqu'à présent, la seule source est Matthew Green, cryptographe et professeur agrégé au Johns Hopkins Information Security Institute.

Selon Green, le plan est initialement d'être côté client - c'est-à-dire de faire toute la détection sur l'iPhone d'un utilisateur. Il fait toutefois valoir qu'il est possible que ce soit le début d'un processus qui mène à la surveillance du trafic de données envoyé et reçu du téléphone.

I’ve had independent confirmation from multiple people that Apple is releasing a client-side tool for CSAM scanning tomorrow. This is a really bad idea.

— Matthew Green (@matthew_d_green) August 4, 2021

Initially I understand this will be used to perform client side scanning for cloud-stored photos. Eventually it could be a key ingredient in adding surveillance to encrypted messaging systems.

— Matthew Green (@matthew_d_green) August 5, 2021

Voici ce que dit l'expert :

À terme, cela pourrait être un ingrédient clé dans l'ajout de la surveillance aux systèmes de messagerie cryptée. La possibilité d'ajouter des systèmes de balayage comme celui-ci aux systèmes de messagerie E2E [cryptage de bout en bout] a été une "demande" majeure des forces de l'ordre du monde entier.

Ce genre d'outil peut être une aubaine pour trouver de la pornographie enfantine dans les téléphones des gens. Mais imaginez ce qu'il pourrait faire entre les mains d'un gouvernement autoritaire ?

Green qui, avec ses étudiants en cryptographie, a déjà fait rapport sur la façon dont les forces de l'ordre peuvent pénétrer dans les iPhones. Lui et l'Université Johns Hopkins ont également déjà travaillé avec Apple pour corriger un bug de sécurité dans Messages.

Mise à jour du soir : Apple a officialisé la nouveauté.

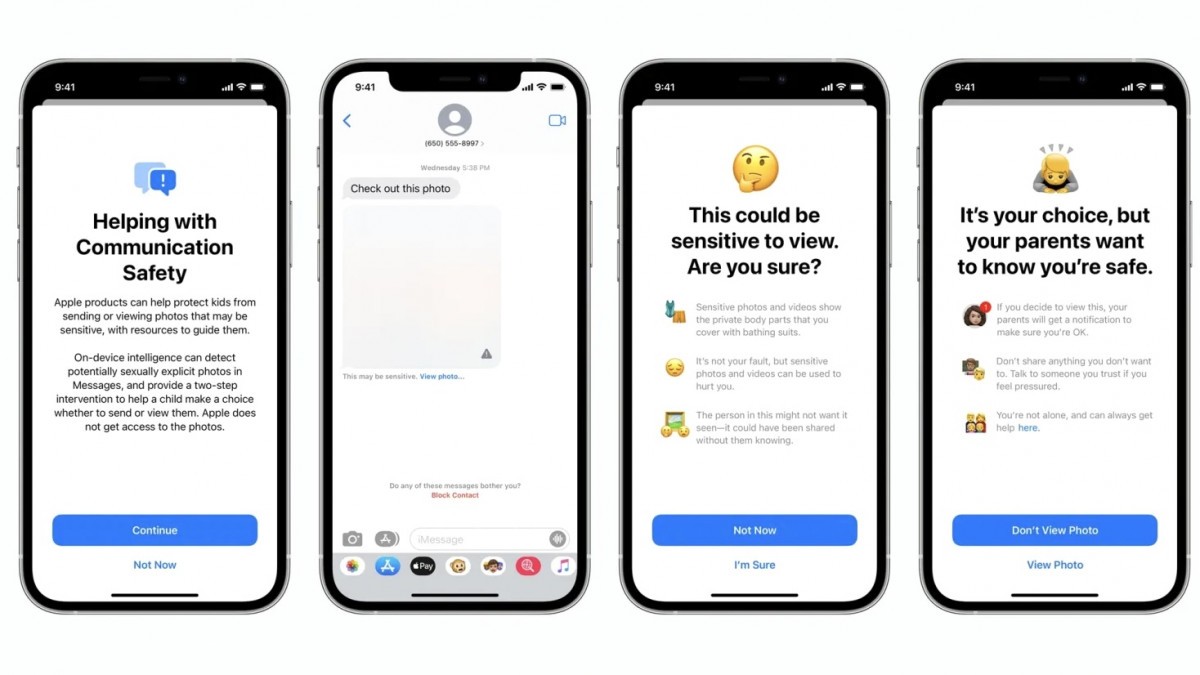

Apple annonce aujourd'hui un trio de nouveaux efforts qu'elle entreprend pour apporter une nouvelle protection pour les enfants sur iPhone, iPad et Mac. Cela inclut de nouvelles fonctionnalités de sécurité des communications dans Messages, une détection améliorée du contenu de matériel pédopornographique (CSAM) dans iCloud et des informations de connaissances mises à jour pour Siri et Spotlight.

Avant qu'une image ne soit stockée dans iCloud Photos, un processus de correspondance sur l'appareil est effectué pour cette image par rapport à l'ensemble illisible de hachages CSAM connus. Ce processus de correspondance est alimenté par une technologie cryptographique appelée intersection d'ensembles privés, qui détermine s'il existe une correspondance sans révéler le résultat. L'intersection d'ensembles privés (PSI) permet à Apple de savoir si un hachage d'image correspond aux hachages d'image CSAM connus, sans rien apprendre sur les hachages d'image qui ne correspondent pas. PSI empêche également l'utilisateur d'apprendre s'il y a eu une correspondance.

A noter que le contrôle des photos se fera uniquement sur iCloud et pour le moment limité aux USA.