iOS 13 : le framework Vision reconnaît les chats et chiens

Medhi Naït Mazi

Medhi Naït Mazi- Il y a 7 ans (Màj il y a 7 ans)

- 💬 Réagir

- 🔈 Écouter

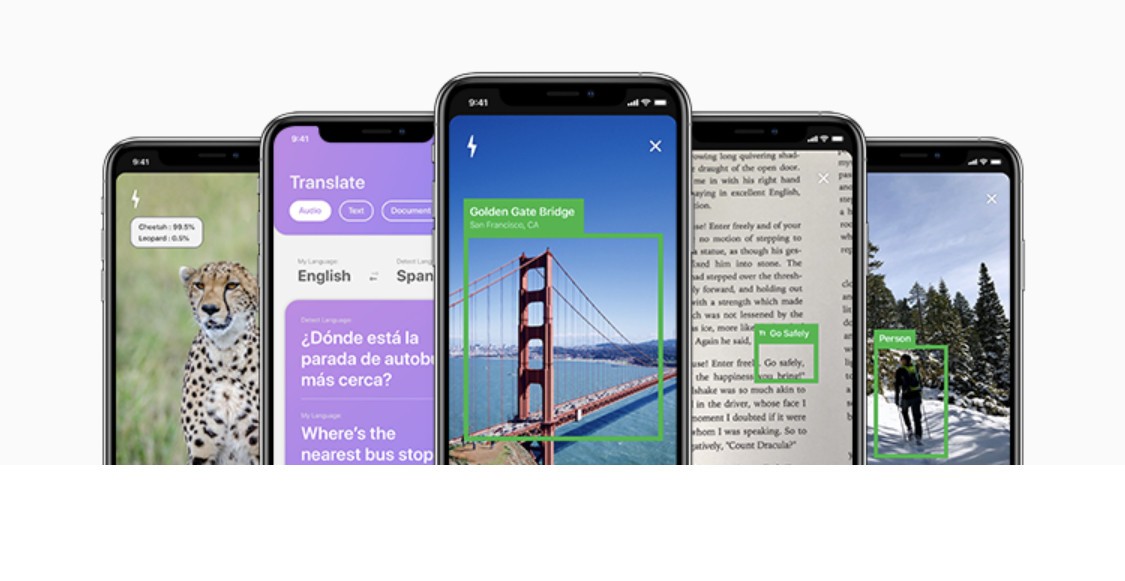

![]() Si iOS 13 regorge de plus 200 nouveautés, Apple en a mis aussi sous le capot. C’est le cas du Machine Learning qui s’octroie de nouveaux algorithmes pour détecter les chiens et les chats dans les flux d’images. Que ce soit photo ou vidéo, les développeurs vont pouvoir en profiter.

Si iOS 13 regorge de plus 200 nouveautés, Apple en a mis aussi sous le capot. C’est le cas du Machine Learning qui s’octroie de nouveaux algorithmes pour détecter les chiens et les chats dans les flux d’images. Que ce soit photo ou vidéo, les développeurs vont pouvoir en profiter.

Un framework d’Apple nommé Vision

La nouvelle version du framework Vision d’Apple propose quelques algorithmes d’apprentissage automatique supplémentaires pour analyser toujours plus finement le contenu des photos et vidéos. Le tout est inclus dans Core ML 3.

Alors qu’il était cantonné aux humains jusqu’ici et aux objets, Vision qui peut s’appuyer sur des modèles Core ML personnalisés, a droit à deux nouvelles API pour les chats et chiens : VNAnimalDetectorCat et VNAnimalDetectorDog. C’est le développeur Frank A. Krueger qui les a repérés sur Twitter, ces dernières étant incluses dans les bêtas d’iOS 13, iPadOS 13, tvOS 13 and macOS Catalina.

Il faut savoir qu’Apple utilise depuis des années le framework Vision pour l’apprentissage automatique dans l’application Photos afin de reconnaître les différentes personnes mais aussi des objets (tapez voiture ou maillot de bain dans Photos, vous verrez) ou encore des animaux. Mais l’objet d’iOS 13 est d’ouvrir ces possibilités aux applications tierces.

D’ailleurs, les devs ont aussi droit à un nouveau logiciel sur Mac pour créer et entraîner leurs propres modèles avec Create ML. De quoi décupler l’intelligence des futures apps sur iPhone, iPad et Mac.