Apple détaille la sécurité de ses outils CSAM

Medhi Naït Mazi

Medhi Naït Mazi- Il y a 5 ans

- 💬 3 coms

- 🔈 Écouter

Apple a partagé un document qui fournit un aperçu plus détaillé des fonctionnalités de sécurité des enfants qu'elle a annoncées pour la première fois la semaine dernière, y compris les principes de conception, les exigences de sécurité et de confidentialité et les considérations relatives aux menaces traitées.

Apple a partagé un document qui fournit un aperçu plus détaillé des fonctionnalités de sécurité des enfants qu'elle a annoncées pour la première fois la semaine dernière, y compris les principes de conception, les exigences de sécurité et de confidentialité et les considérations relatives aux menaces traitées.

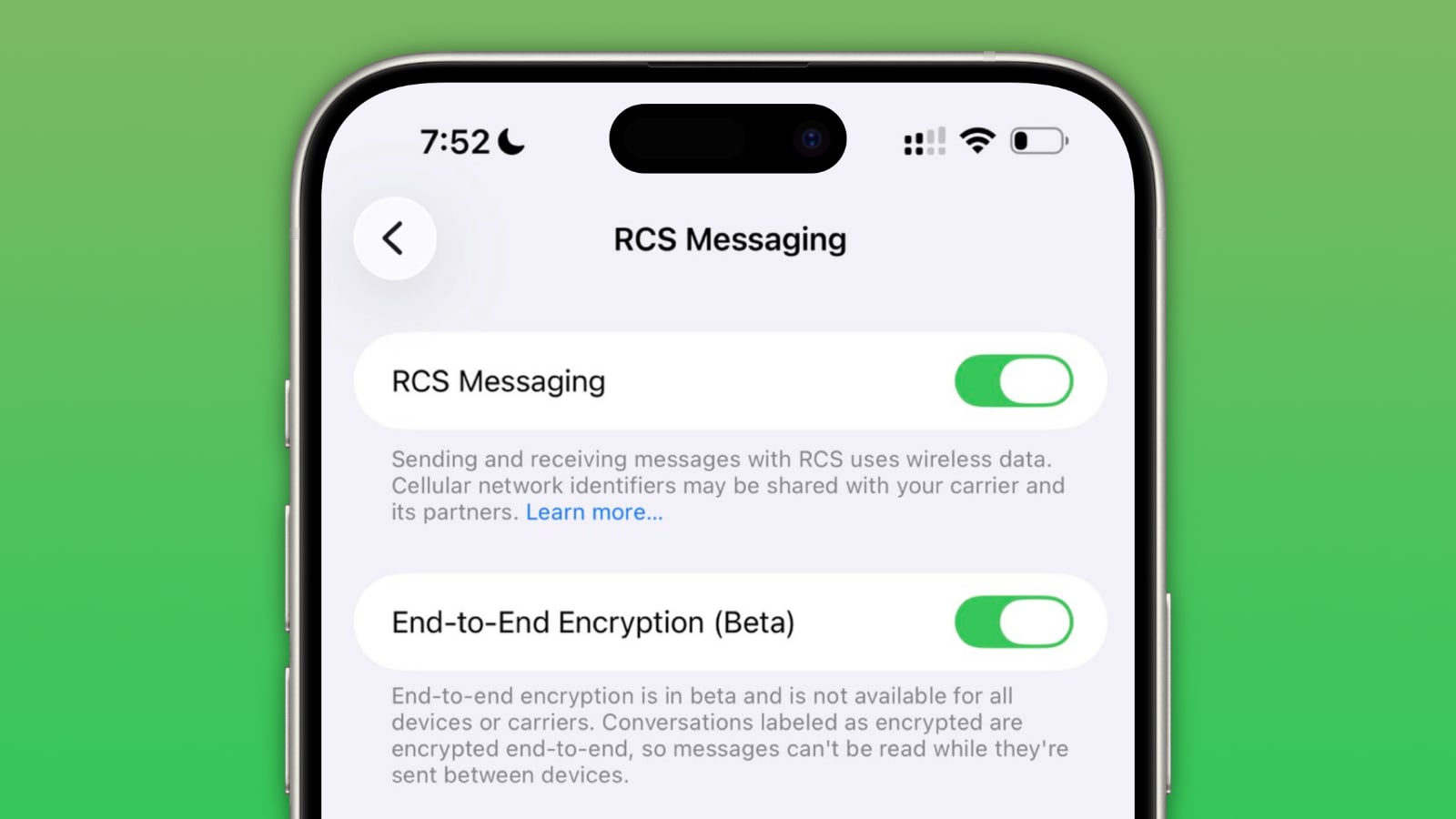

Un seuil de déclenchement à 30 images sensibles

L'intention d'Apple de détecter les images connues de matériel d'abus pédosexuel (CSAM) stockées dans les photos iCloud a été particulièrement controversé et a suscité des préoccupations de la part de certains chercheurs en sécurité, de l'organisation à but non lucratif Electronic Frontier Foundation et d'autres grands noms de l’industrie. Pour eux, ce système peut potentiellement être détourné par les gouvernements pour la surveillance de masse.

Le document vise à répondre à ces préoccupations et réitère certains détails qui ont fait surface un peu plus tôt dans une interview avec Craig Federighi, chef du génie logiciel d'Apple, notamment que la firme a prévu de fixer un seuil de correspondance initial de 30 images CSAM connues avant qu'un compte iCloud ne soit signalé pour examen manuel par l'entreprise.

Apple a également déclaré que la base de données sur l'appareil d'images CSAM connues ne contient que des entrées qui ont été soumises indépendamment par deux ou plusieurs organisations de sécurité des enfants opérant dans des juridictions souveraines distinctes et non sous le contrôle du gouvernement.

Le système est conçu de sorte qu'un utilisateur n'ait pas besoin de faire confiance à Apple, à une autre entité unique ou même à tout un ensemble d'entités pouvant entraîner une collusion de la même juridiction souveraine (c'est-à-dire sous le contrôle du gouvernement) pour être sûr que le système fonctionne comme annoncé. Cela est réalisé grâce à plusieurs mécanismes imbriqués, y compris la vérifiabilité intrinsèque d'une seule image logicielle distribuée dans le monde entier pour exécution sur l'appareil, une exigence selon laquelle tout hachage d'image perceptuelle inclus dans la base de données CSAM cryptée sur l'appareil soit fourni indépendamment par deux organisations de sécurité des enfants ou plus de juridictions souveraines distinctes, et enfin, un processus d'examen humain pour empêcher tout signalement erroné.

Apple a ajouté qu'elle publiera sur son site Web un document d'assistance contenant un hachage racine de la base de données CSAM cryptée incluse avec chaque version du système d'exploitation Apple qui prend en charge la fonctionnalité. On parle d’iOS 15, iPadOS 15 et MacOS 12. En outre, Apple a déclaré que les utilisateurs seront en mesure d'inspecter le hachage racine de la base de données cryptée présente sur leur appareil et de le comparer au hachage racine attendu dans le document d'assistance. Aucun délai n'a été prévu pour cela.

Les employés seront formés pour répondre sur les questions de photos d’abus sexuel

Dans une note de service obtenue par Mark Gurman de Bloomberg, Apple a déclaré qu'elle demanderait également à un auditeur indépendant d'examiner le système. La note de service indiquait que les employés des magasins Apple pouvaient recevoir des questions des clients sur les fonctionnalités de sécurité des enfants et était liée à une FAQ qu'Apple a partagée plus tôt cette semaine comme ressource que les employés peuvent utiliser pour répondre aux questions et fournir plus de clarté et de transparence aux clients.

Apple a d'abord déclaré que les nouvelles fonctionnalités de sécurité des enfants arriveraient sur l'iPhone, l'iPad et le Mac avec des mises à jour logicielles plus tard cette année, et la société a déclaré que les fonctionnalités ne seraient disponibles aux États-Unis qu'au lancement. Malgré les critiques, Apple a précisé qu'elle n'avait apporté aucun changement à ce calendrier…