L'ancien chef de la sécurité de chez Facebook parle des outils CSAM d'Apple

Alban Martin

Alban Martin- Il y a 5 ans (Màj il y a 5 ans)

- 💬 Réagir

- 🔈 Écouter

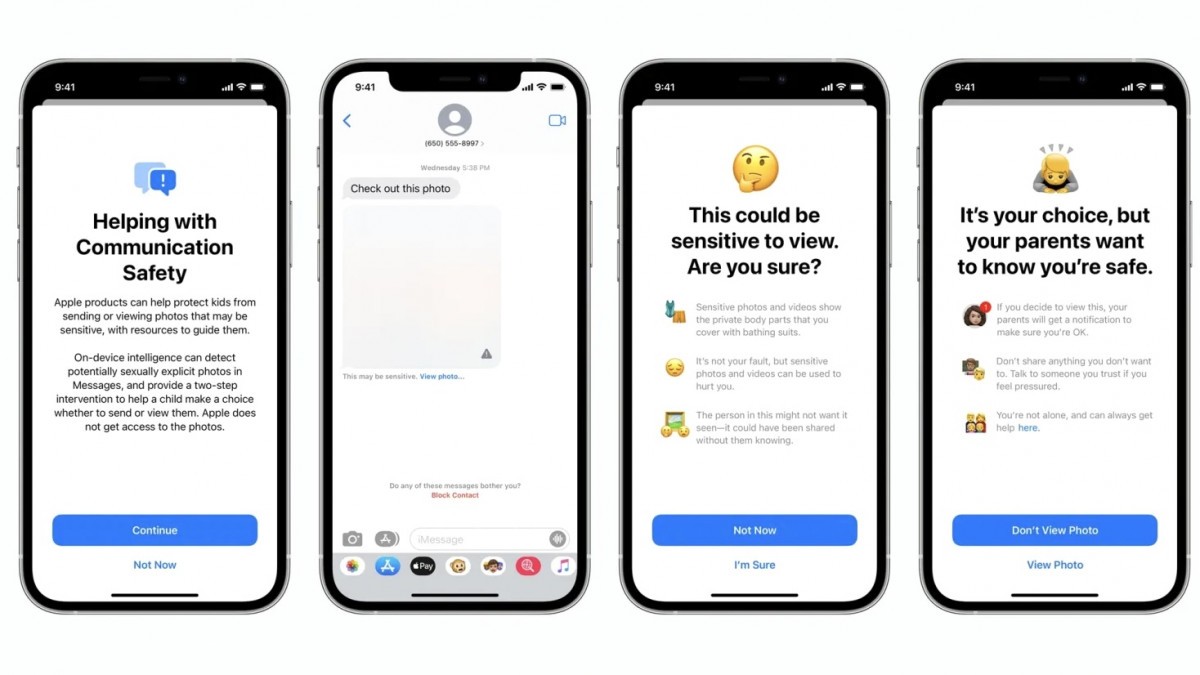

Au milieu de la controverse autour des nouvelles fonctionnalités de sécurité des enfants d'Apple qui impliqueraient la numérisation des messages et des photos des utilisateurs, l'ancien chef de la sécurité de Facebook, Alex Stamos, a amené sa pierre à l'édifice.

Au milieu de la controverse autour des nouvelles fonctionnalités de sécurité des enfants d'Apple qui impliqueraient la numérisation des messages et des photos des utilisateurs, l'ancien chef de la sécurité de Facebook, Alex Stamos, a amené sa pierre à l'édifice.

Pas de réponse facile mais une manière qui déplaît

Dans un fil de discussion sur Twitter, Stamos a déclaré qu'il n'y avait "pas de réponses faciles" dans le débat sur la protection de l'enfance par rapport à la vie privée.

Stamos a exprimé sa frustration face à la façon dont Apple a géré l'annonce des nouvelles fonctionnalités et a critiqué l'entreprise pour ne pas s'être engagée dans des discussions plus larges sur les aspects de sécurité et de confidentialité du chiffrement de bout en bout ces dernières années.

Apple a été invité, mais a refusé de participer à ces discussions, et avec cette annonce, ils ont juste poussé tout le monde dans les coins les plus reculés sans consultation ou débat public.

De même, Stamos s'est dit déçu par diverses ONG, telles que l'Electronic Frontier Foundation (EFF) et le National Center for Missing & Exploited Children (NCMEC), pour avoir laissé peu de place à la discussion dans leurs déclarations publiques. Le NCMEC, par exemple, a qualifié les employés d'Apple qui ont remis en question les implications des nouvelles fonctionnalités sur la vie privée "de voix criardes de la minorité". "Le geste public d'Apple les a poussés à défendre leurs actions à l'extrême", a expliqué Stamos.

Stamos a exhorté les chercheurs en sécurité et les militants qui ont été surpris par l'annonce d'Apple à accorder une plus grande attention à l'environnement réglementaire mondial, et a spéculé que le Online Safety Bill du Royaume-Uni et la Digital Services Act de l'UE étaient essentiels à la décision d'Apple de mettre en œuvre les nouvelles fonctionnalités de sécurité des enfants.

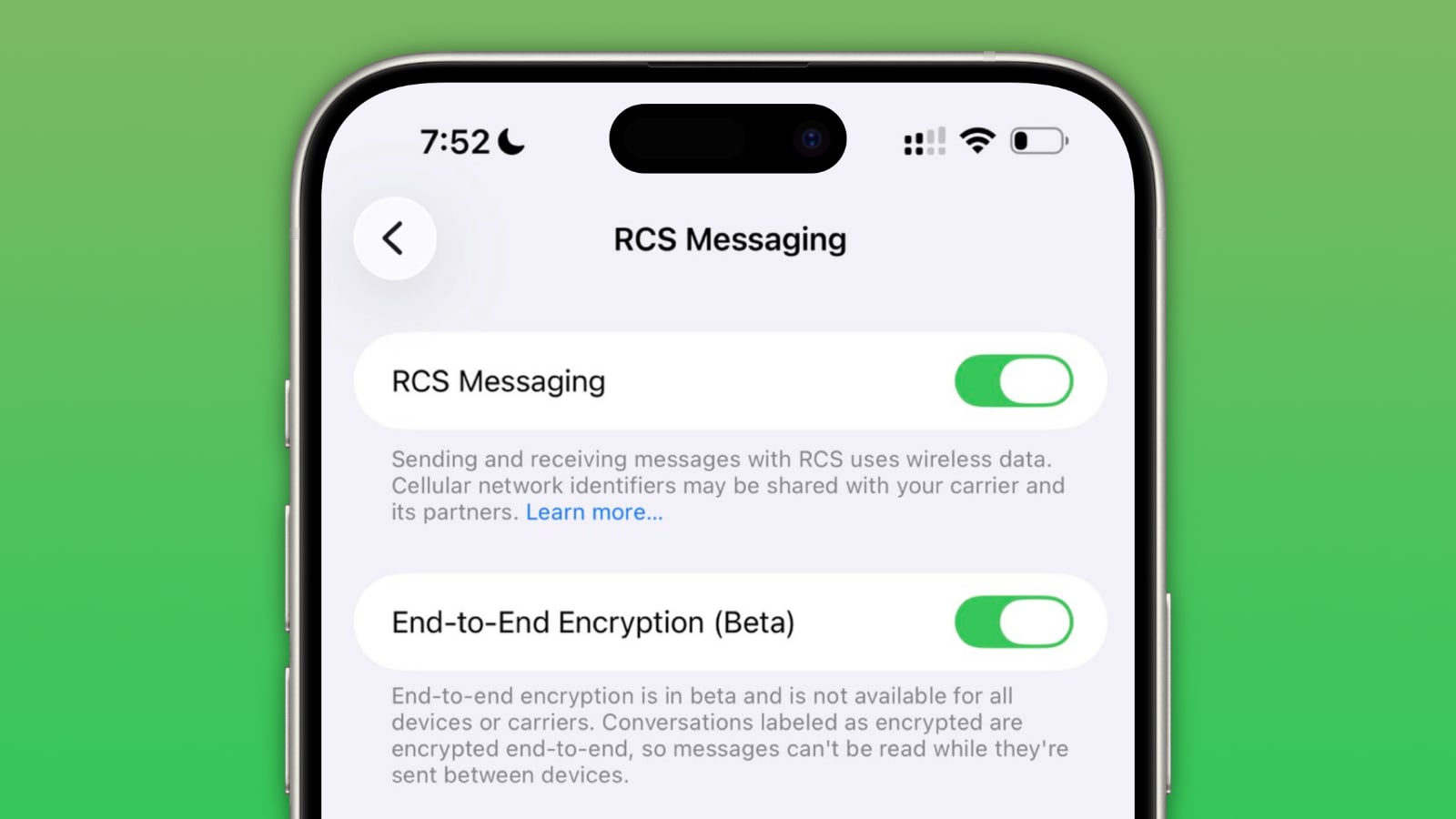

L'un des problèmes fondamentaux de l'approche d'Apple est qu'ils semblent désespérés d'éviter d'établir une véritable fonction de confiance et de sécurité pour leurs produits de communication. Il n'existe aucun mécanisme pour signaler le spam, les menaces de mort, les discours de haine, le NCII ou tout autre type d'abus sur iMessage.

Il a également déclaré qu'Apple n'a pas suffisamment de fonctions pour la confiance et la sécurité, et a encouragé Apple à créer un système de signalement dans iMessage, à déployer le machine learning côté client pour inciter les utilisateurs à signaler quelque chose d'abusif et à créer une équipe de sécurité des enfants pour enquêter sur les pires rapports.

Au lieu de cela, nous obtenons un système de ML qui ne s'adresse qu'aux (moins de) 13 ans (pas le plus grand groupe possible), qui donne aux enfants un choix qu'ils ne sont pas équipés pour faire et qui avise les parents au lieu d'Apple.

Stamos a déclaré qu'il ne comprenait pas pourquoi Apple recherche des images répertoriées dans la CSAM localement, et a averti qu'Apple pourrait avoir "empoisonné" l'opinion contre les analyseurs côté client.

Je ne comprends pas non plus pourquoi Apple pousse le balayage CSAM pour iCloud dans l'appareil, à moins qu'il ne soit en préparation d'un véritable chiffrement des sauvegardes iCloud. Une cible raisonnable devrait être la numérisation des albums iCloud partagés, qui pourrait être implémentée côté serveur.

Quoi qu'il en soit, sortir sans crier gare avec une numérisation non consensuelle de photos locales et créer un ML côté client qui n'offrira pas beaucoup de prévention réelle des dommages signifie qu'Apple a peut-être juste empoisonné le bien contre toute utilisation de classificateurs côté client pour protéger les utilisateurs.

Néanmoins, Stamos a souligné que Facebook a attrapé 4,5 millions d'utilisateurs publiant des images de maltraitance d'enfants, et que cela ne représente probablement qu'une proportion du nombre total de délinquants, en recherchant des images avec des correspondances connues du côté du CSAM - Child Sexual Abuse Material.