🔥 Apple dévoile les nouveautés d'accessibilité d'iOS 19, macOS 16, watchOS 12 et visionOS 3

Alban Martin

Alban Martin- Il y a 10 mois (Màj il y a 9 mois)

- 💬 Réagir

- 🔈 Écouter

![]() À un mois du lancement de la WWDC 25 le 9 juin prochain, Apple a officiellement présenté aujourd'hui les nouvelles fonctionnalités d'accessibilité à venir pour iPhone, iPad, Mac, Apple Watch et Apple Vision Pro. Ces fonctionnalités marquent les 40 ans d'innovation en accessibilité, l'entreprise ayant créé son bureau dédié aux handicaps en 1985. C'est aussi le premier aperçu des nouveautés liées à iOS 19, macOS 16, watchOS 12 et autre visionOS 3.

À un mois du lancement de la WWDC 25 le 9 juin prochain, Apple a officiellement présenté aujourd'hui les nouvelles fonctionnalités d'accessibilité à venir pour iPhone, iPad, Mac, Apple Watch et Apple Vision Pro. Ces fonctionnalités marquent les 40 ans d'innovation en accessibilité, l'entreprise ayant créé son bureau dédié aux handicaps en 1985. C'est aussi le premier aperçu des nouveautés liées à iOS 19, macOS 16, watchOS 12 et autre visionOS 3.

L'écosystème Apple sera plus accessible que jamais

Tim Cook, PDG d'Apple, a déclaré :

Chez Apple, l'accessibilité fait partie de notre ADN. Créer une technologie pour tous est une priorité pour nous, et nous sommes fiers des innovations que nous partageons cette année. Cela inclut des outils pour aider les gens à accéder à des informations cruciales, explorer le monde qui les entoure et faire ce qu'ils aiment.

Bien que ces fonctionnalités arriveront avec les mises à jour majeures de l'année, notamment iOS 19, Apple évite toutefois de mentionner explicitement « iOS 19 » (ou tout autre système encore non dévoilé) pour l'instant. Parmi les nouveautés, on trouve des étiquettes d'accessibilité sur l'App Store, une application Loupe pour Mac, les sous-titres en direct sur Apple Watch, des améliorations majeures pour la "Voix Personnelle", et bien plus.

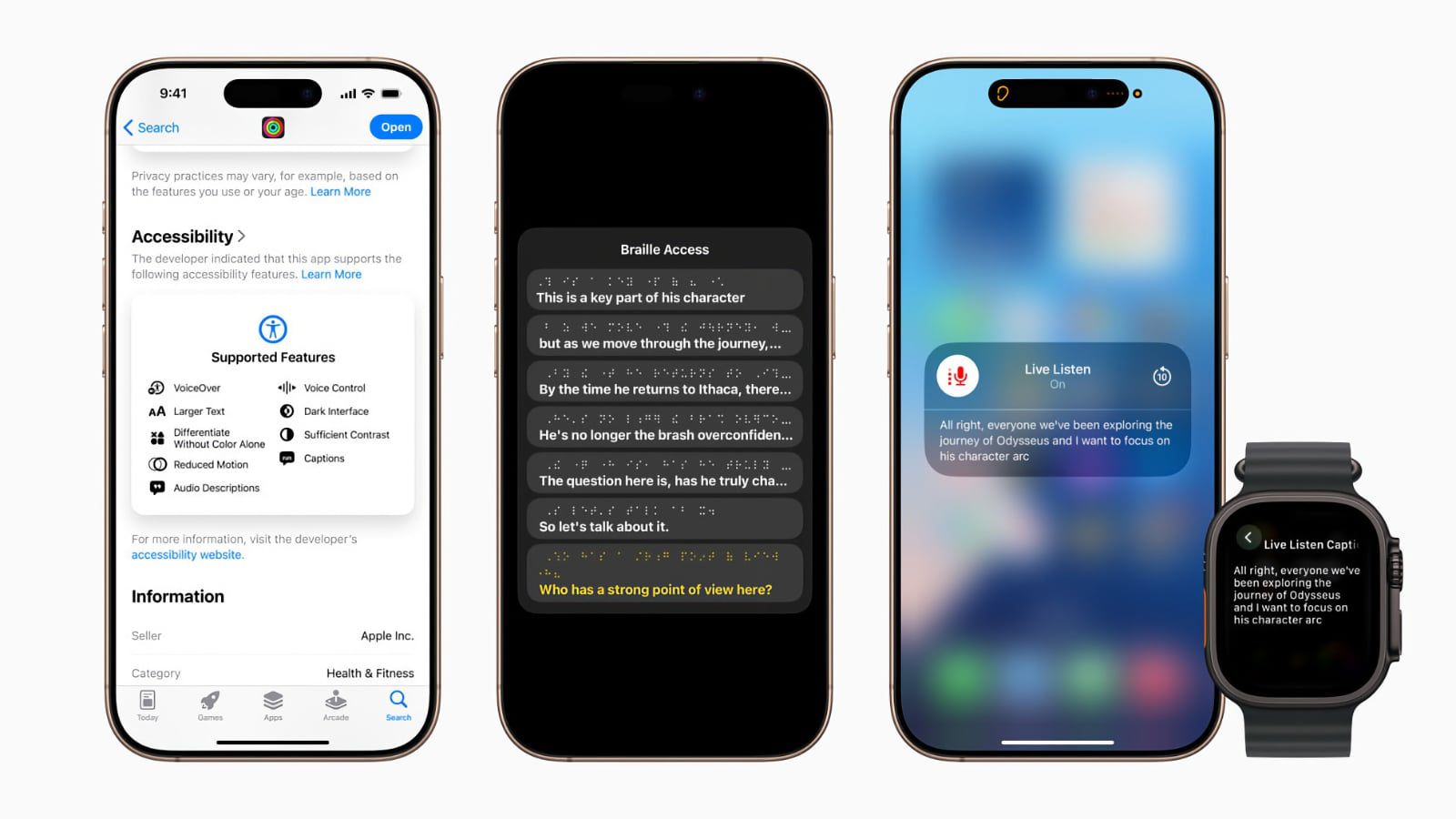

Étiquettes d'accessibilité sur l'App Store

Au cœur de l'annonce des nouvelles fonctionnalités d'accessibilité d'iOS 19, Apple met à jour l'App Store. Plus tard cette année, une nouvelle section d'étiquettes d'accessibilité sera ajoutée aux fiches des applications. Similaire aux étiquettes de confidentialité lancées il y a deux ans, cette fonctionnalité permettra aux utilisateurs de voir facilement les pratiques d'accessibilité des applications avant de les télécharger. On retrouvera ainsi les fonctionnalités prises en charge par une application, comme VoiceOver, Contrôle Vocal, Texte Agrandi, Contraste Suffisant, Mouvement Réduit, sous-titres, et plus encore.

Loupe pour Mac

Apple introduira pour la première fois son application Loupe sur Mac avec macOS 16. Disponible sur iPhone et iPad depuis 2016, la loupe aide les utilisateurs aveugles ou malvoyants à zoomer, lire du texte et détecter des objets autour d'eux.

La nouvelle application Loupe pour Mac fonctionne avec un iPhone connecté via la caméra de continuité ou une caméra USB. Les utilisateurs peuvent zoomer sur leur environnement directement dans l'application sur leur Mac, ajuster la perspective, la luminosité, le contraste, les couleurs, et plus encore pour faciliter la lecture. L'application peut également reconnaître du texte, grâce à Apple Intelligence.

Par exemple, Loupe sur Mac peut zoomer sur un tableau blanc lors d'une réunion ou d'un cours, reconnaître intelligemment le texte manuscrit et le rendre plus lisible directement sur l'écran du Mac.

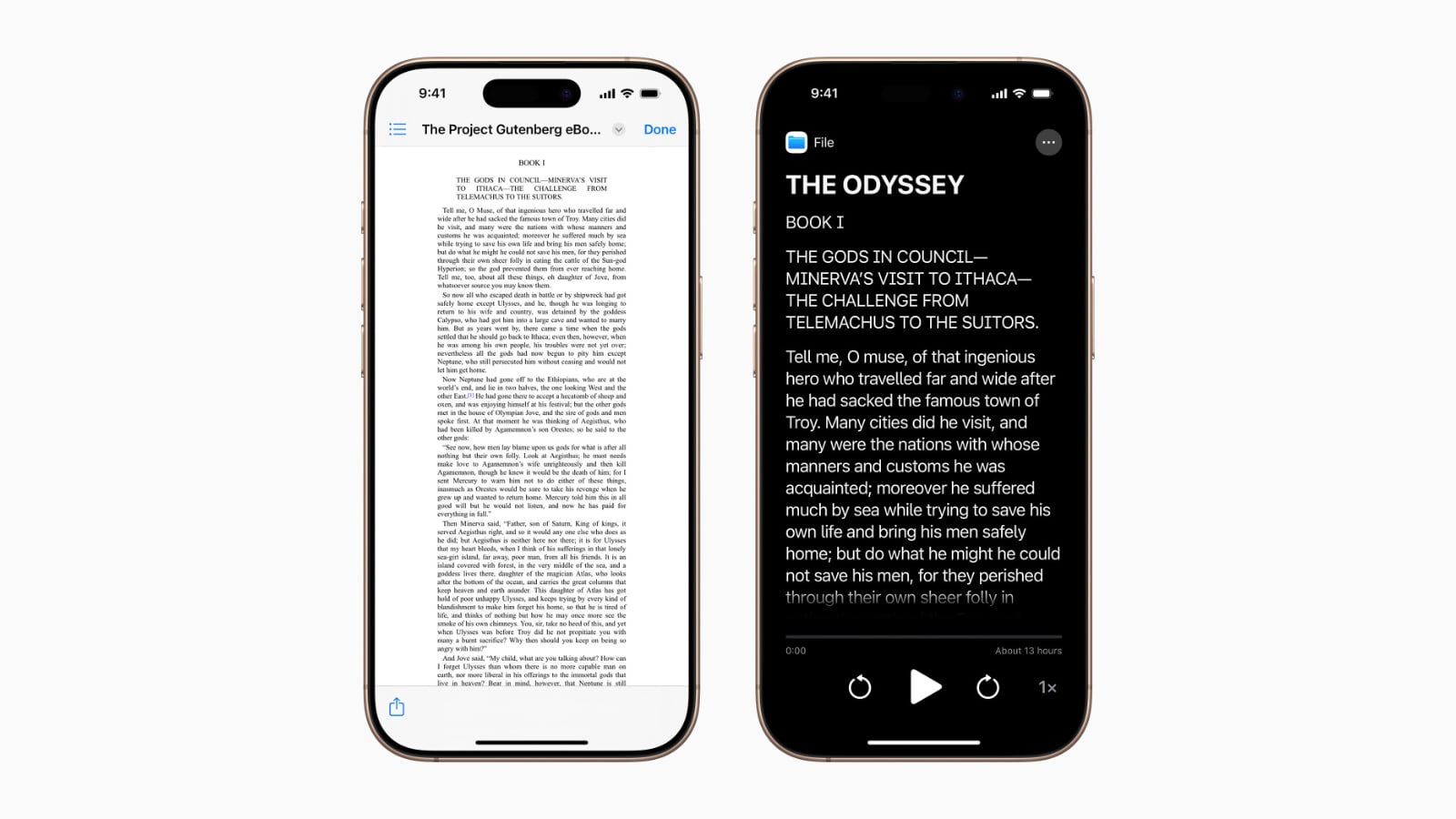

Lecteur d'accessibilité

Le lecteur d'accessibilité est une nouvelle fonctionnalité système conçue pour faciliter la lecture de texte pour les utilisateurs ayant divers handicaps, comme la dyslexie ou une basse vision. Disponible sur iPhone, iPad, Mac et Apple Vision Pro, ce mode offre des options de personnalisation pour la police, la couleur, l'espacement, et prend en charge la lecture vocale. Auparavant cantonné à Safari, il peut être lancé depuis n'importe quelle application et est intégré à l'application Loupe sur iOS, iPadOS et macOS, permettant d'interagir avec du texte dans le monde réel, comme dans des livres ou des menus.

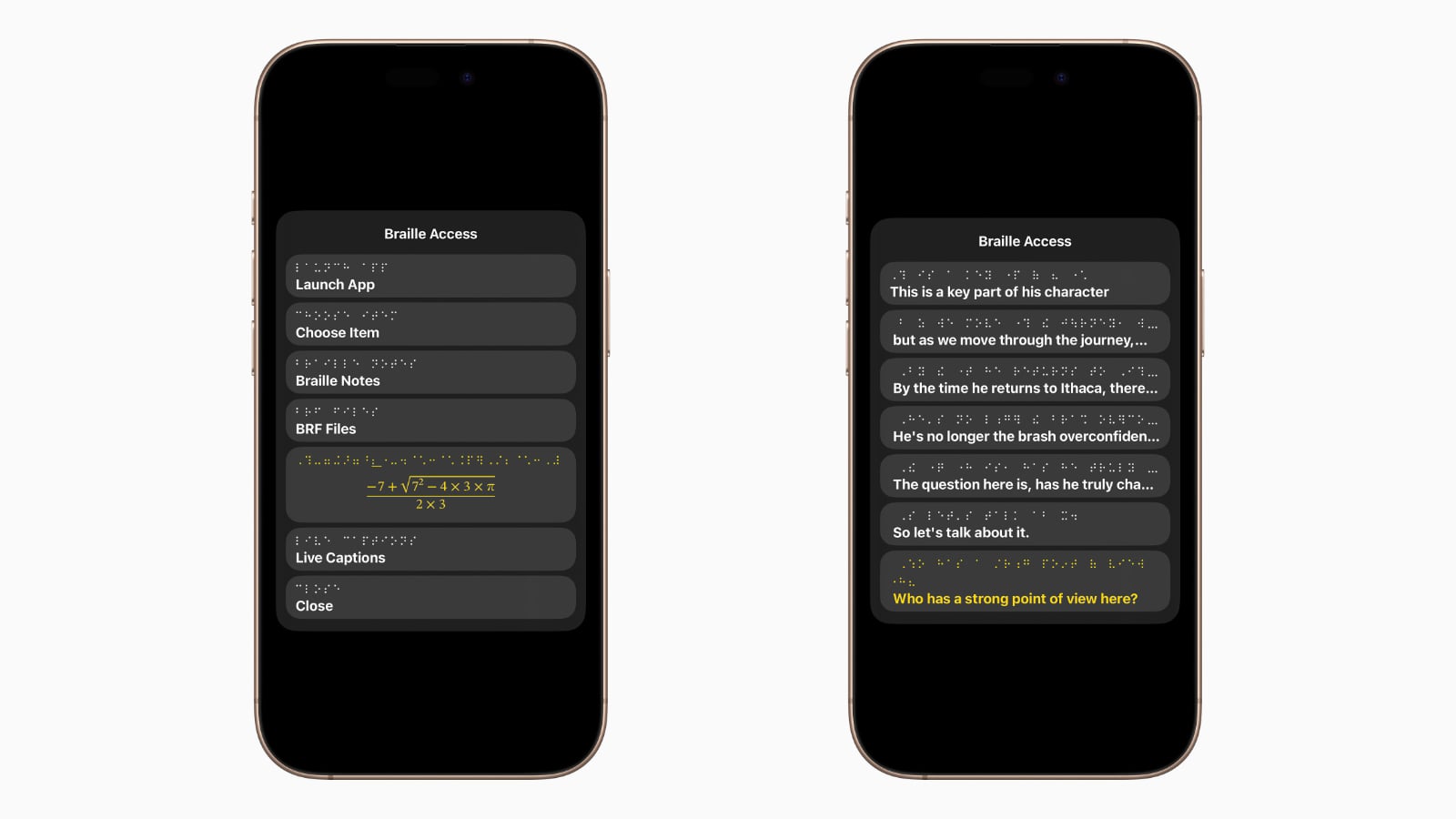

Accès au braille

Apple annonce que son expérience d'accès au braille transforme un appareil Apple en un outil de prise de notes en braille entièrement intégré à l'écosystème Apple.

Avec un lanceur d'applications intégré, les utilisateurs peuvent ouvrir n'importe quelle application en tapant avec l'entrée braille à l'écran ou un appareil braille connecté. Avec l'accès au braille, les utilisateurs peuvent prendre des notes rapidement en braille et effectuer des calculs avec le braille Nemeth, souvent utilisé en classe pour les mathématiques et les sciences.

Les utilisateurs peuvent également ouvrir des fichiers BRF (Braille Ready Format) directement depuis l'accès au braille, débloquant une large gamme de livres et fichiers créés sur des appareils de prise de notes en braille. Cette fonctionnalité s'intègre aux sous-titres en direct (apparus sur iOS 16) pour transcrire des conversations en temps réel sur des afficheurs braille.

Sous-titres en direct sur Apple Watch

Concernant les sous-titres en direct, watchOS 12, prévu pour cette année, apportera des contrôles d'écoute en direct à l'Apple Watch pour la première fois. Introduite sur iPhone avec iOS 12 en 2018, l'écoute en direct utilise le micro de l'iPhone pour diffuser du contenu directement vers des AirPods ou des aides auditives compatibles.

Avec watchOS 12, les contrôles d'écoute en direct seront disponibles sur Apple Watch, permettant de démarrer ou arrêter des sessions à distance, revenir en arrière pour rattraper un moment manqué, et plus encore. Les sous-titres en direct en temps réel permettront également de suivre une conversation via des transcriptions sur l'Apple Watch.

Améliorations pour Vision Pro

Apple annonce aussi de nouvelles fonctionnalités d'accessibilité pour son Vision Pro cette année, probablement avec visionOS 3 :

Pour les utilisateurs aveugles ou malvoyants, visionOS utilisera le système de caméra avancé pour étendre les fonctionnalités d'accessibilité visuelle. Avec des mises à jour puissantes pour le zoom, les utilisateurs pourront agrandir tout ce qui est en vue, y compris leur environnement, via la caméra principale. Pour les utilisateurs de VoiceOver, la reconnaissance en direct dans visionOS utilise l'apprentissage automatique pour décrire les environs, trouver des objets, lire des documents, et plus encore. Une nouvelle API permettra aux applications approuvées, comme Be My Eyes, d'accéder à la caméra principale pour une assistance visuelle en direct.

Améliorations de Voix Personnelle

Apple a lancé la voix personnelle avec iOS 17 en 2023, permettant aux personnes risquant de perdre leur capacité à parler de créer une voix qui leur ressemble. Conçue pour des utilisateurs atteints de maladies comme la SLA, elle s'intègre à la parole en direct pour lire à voix haute ce que l'utilisateur tape.

Initialement, la configuration nécessitait d'enregistrer 150 phrases pour entraîner le modèle d'apprentissage automatique, avec un traitement overnight. Avec iOS 19, Apple simplifie ce processus : seulement 10 phrases suffisent, avec un traitement en moins d'une minute, pour une voix plus fluide et naturelle. La fonctionnalité prendra également en charge l'espagnol (Mexique) cette année.

Autres fonctionnalités d'accessibilité à venir

Ces fonctionnalités ne sont que la partie visible de l'iceberg. Apple prévoit de nombreuses autres améliorations de l'existant d'après son communiqué, notamment pour le suivi oculaire, les sons d'arrière-plan, la reconnaissance sonore, et plus encore :

- Sons d'arrière-plan : personnalisation facilitée avec de nouveaux réglages d'égaliseur, arrêt automatique après un certain temps, et actions pour les automatisations dans Raccourcis.

- Voix Personnelle : plus rapide et puissante, avec une voix plus naturelle en moins d'une minute à partir de 10 phrases, et prise en charge de l'espagnol (Mexique).

- Cues de mouvement en véhicule : disponibles sur Mac, avec personnalisation des points animés à l'écran sur iPhone, iPad et Mac pour réduire le mal des transports.

- Suivi oculaire : options pour utiliser un interrupteur ou un temps de fixation pour les sélections, et améliorations pour la saisie au clavier.

- Suivi de la tête : contrôle de l'iPhone et de l'iPad par mouvements de la tête, similaire au suivi oculaire.

- Interfaces cerveau-ordinateur (BCI) : nouveau protocole pour le contrôle par interrupteur sur iOS, iPadOS et visionOS, pour les utilisateurs à mobilité sévèrement réduite.

- Accès assisté : nouvelle application Apple TV simplifiée et API pour des expériences adaptées aux handicaps intellectuels et développementaux.

- Haptique musicale : personnalisation sur iPhone avec options pour les voix ou une chanson entière, et réglage de l'intensité des vibrations.

- Reconnaissance sonore : nouvelle reconnaissance des noms pour les utilisateurs sourds ou malentendants.

- Contrôle vocal : mode programmation dans Xcode, synchronisation du vocabulaire entre appareils, et prise en charge de nouvelles langues (coréen, arabe, turc, etc.).

- Sous-titres en direct : prise en charge de nouvelles langues, dont l'anglais (Inde, Australie, etc.), le mandarin, l'espagnol, le français, et plus encore.

- CarPlay : prise en charge du texte agrandi et reconnaissance sonore pour les pleurs de bébé, en plus des klaxons et sirènes.

- Partage des paramètres d'accessibilité : partage temporaire des paramètres avec un autre iPhone ou iPad, idéal pour emprunter un appareil ou utiliser un kiosque public.

Apple lance la Release Candidate d'iOS 18.3, macOS 15.3, tvOS 18.3, visionOS 2.3 et watchOS 11.3

Apple lance la Release Candidate d'iOS 18.3, macOS 15.3, tvOS 18.3, visionOS 2.3 et watchOS 11.3