Un scanner LiDAR sur les Apple Glass pour la nuit ?

Alban Martin

Alban Martin- Il y a 5 ans

- 💬 Réagir

- 🔈 Écouter

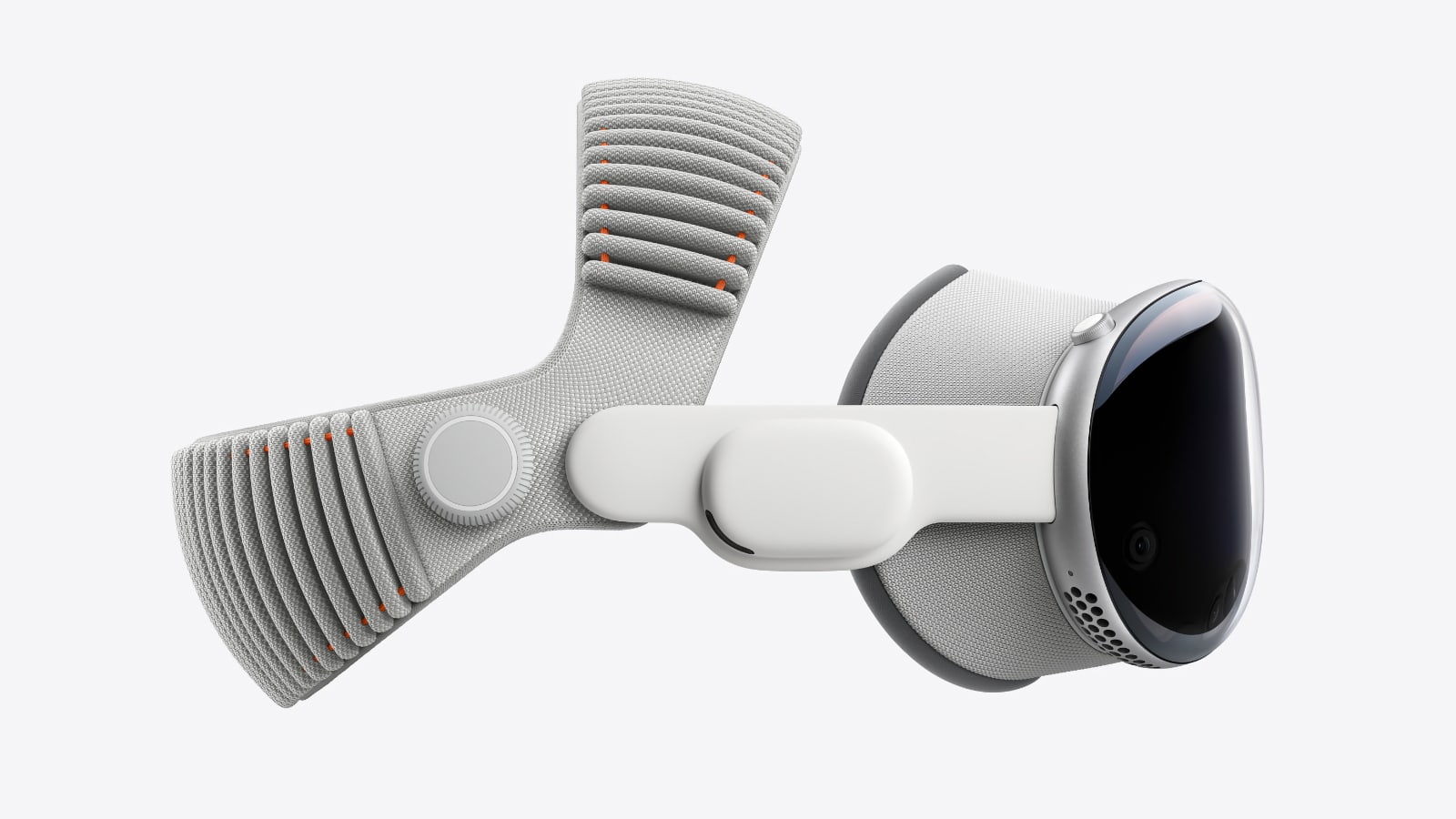

![]() Après l'apparition du scanner Lidar sur iPad Pro puis les iPhone 12 Pro cette année, Apple pourrait intégrer sa technologie sur ses lunettes AR, les Apple Glass.

Après l'apparition du scanner Lidar sur iPad Pro puis les iPhone 12 Pro cette année, Apple pourrait intégrer sa technologie sur ses lunettes AR, les Apple Glass.

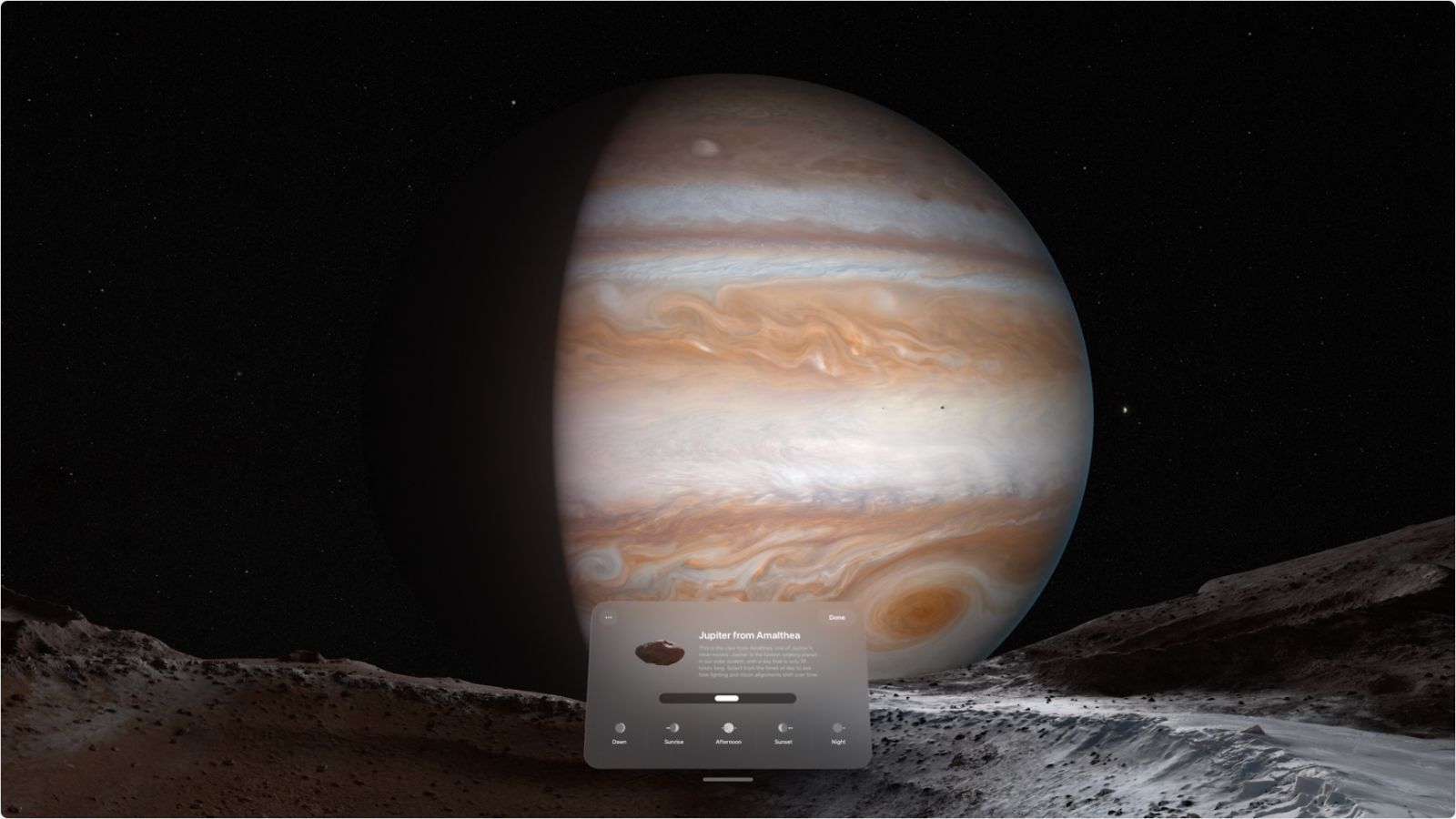

Attendues de longues dates, les lunettes seraient fonctionnelles et la firme chercherait à optimiser son utilisation en conditions dégradées. C'est ainsi qu'un nouveau brevet détaille un système d’amélioration de la visibilité en basse lumière. Il s'agit d'un travail similaire à la détection d'obstacle vu récemment.

Des lunettes avec un Lidar chez Apple

Nous découvrons petit à petit l'objectif d'Apple pour le capteur LiDAR dans des appareils tels que l'iPhone 12 Pro, qui l'utilise pour aider à la mise au point automatique. Cette aide à la mise au point est particulièrement utile dans les environnements à faible éclairage - et Apple entend faire de même sur ses lunettes AR.

Le brevet intitulé «Head-Mounted Display with Low Light Operation» est une demande récemment déposée, qui décrit de multiples façons de détecter l'environnement autour du porteur de l'accessoire.

Apple commence en expliquant que les yeux humains ont une sensibilité différente selon différentes conditions d'éclairage. Le document détaille ensuite de nombreuses formes différentes de vision humaine, de la photopique au mésopique, où les différents types ou quantités de lumière dépendent de différentes cellules coniques de l'œil.

La vision photopique est décrite comme la façon dont l'œil fonctionne pendant des niveaux élevés de lumière ambiante, comme la lumière du jour. En revanche, en cas de conditions dégradées, c'est une autre histoire.

Par rapport à la vision photopique, la vision mésopique peut entraîner une perte de vision des couleurs, une modification de la sensibilité à différentes longueurs d'onde de lumière, une diminution de l'acuité et plus de flou de mouvement. Ainsi, dans des conditions mal éclairées, en se fiant à la vision scotopique, une personne est moins capable de voir l'environnement.

Pour contourner le problème, Apple entend utiliser des capteurs dans un système d'affichage portatif, tels que les Apple Glass, qui scannent l'environnement.

La clé de l'enregistrement de l'environnement est la capacité de détecter les distances entre les objets, la capacité de détecter la profondeur. L'affichage reproduirait alors en AR la forme de l'objet repéré. Voilà pourquoi la firme veut intégrer le Lidar que l'on connait également dans la conduite autonome par exemple ou même les système de régulateurs de vitesse.

Cette technologie pourrait aussi éviter le "mal de mer" avec la technologie AR, aussi appelée Motion Sickness.

En tout cas, on a hâte qu'Apple nous dévoile ses lunettes, certainement l'an prochain à la WWDC 2021.