Apple ouvrirait ses outils anti pedopornographie aux apps tierces

Medhi Naït Mazi

Medhi Naït Mazi- Il y a 5 ans

- 💬 Réagir

- 🔈 Écouter

Apple a tenu hier soir une séance de questions-réponses avec des journalistes concernant ses nouvelles fonctionnalités de sécurité des enfants, et au cours de la séance d'information, Apple a confirmé qu'elle serait ouverte à l'extension des fonctionnalités aux applications tierces à l'avenir. Une nouvelle prise de parole après les vives critiques qui se sont rapidement faire entendre.

Apple a tenu hier soir une séance de questions-réponses avec des journalistes concernant ses nouvelles fonctionnalités de sécurité des enfants, et au cours de la séance d'information, Apple a confirmé qu'elle serait ouverte à l'extension des fonctionnalités aux applications tierces à l'avenir. Une nouvelle prise de parole après les vives critiques qui se sont rapidement faire entendre.

Pour mémoire, Apple a dévoilé trois nouvelles fonctionnalités de sécurité pour enfants à venir dans les futures versions d'iOS 15, iPadOS 15, macOS Monterey et/ou watchOS 8.

Nouvelles fonctionnalités de sécurité pour enfants d'Apple

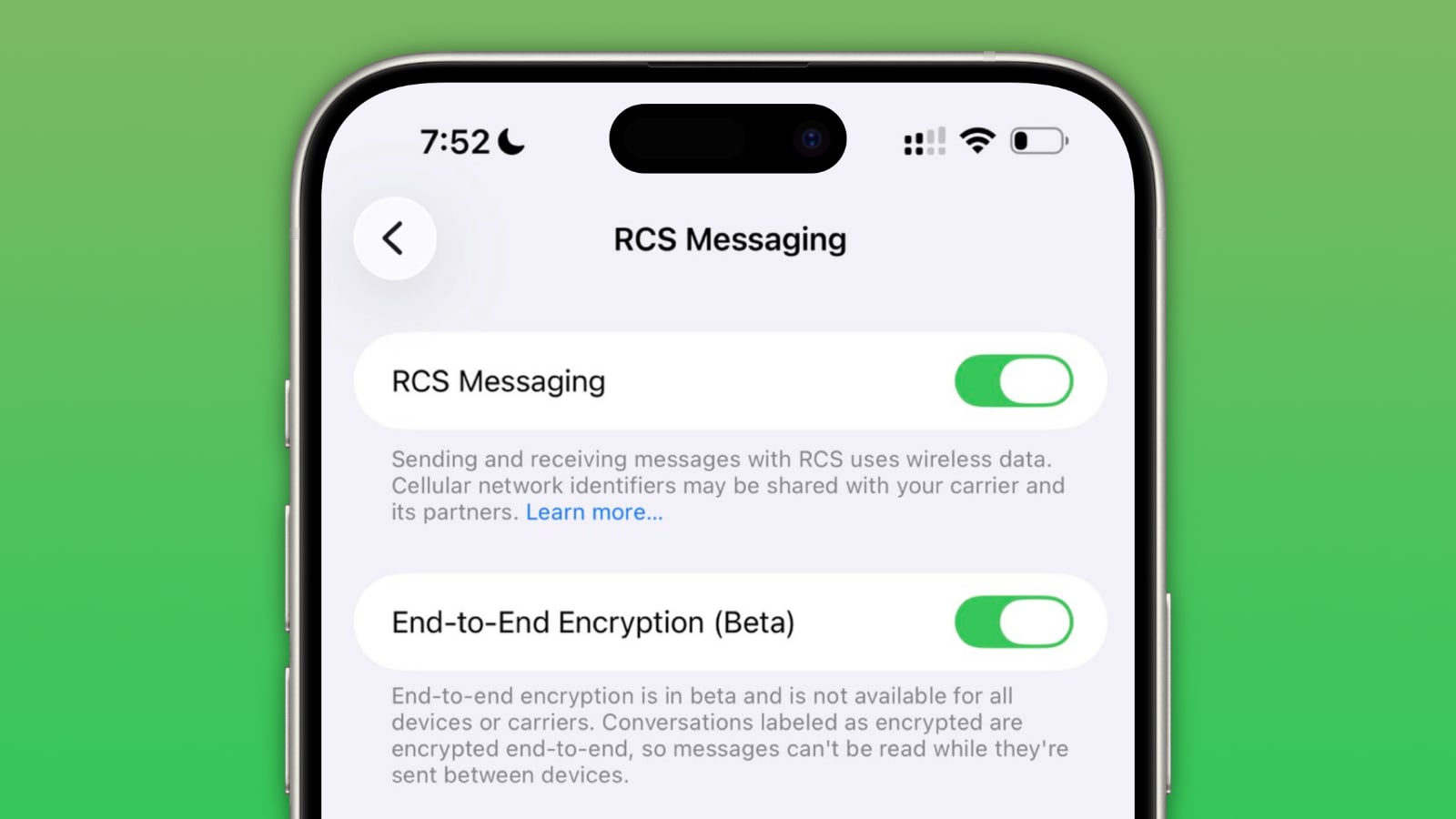

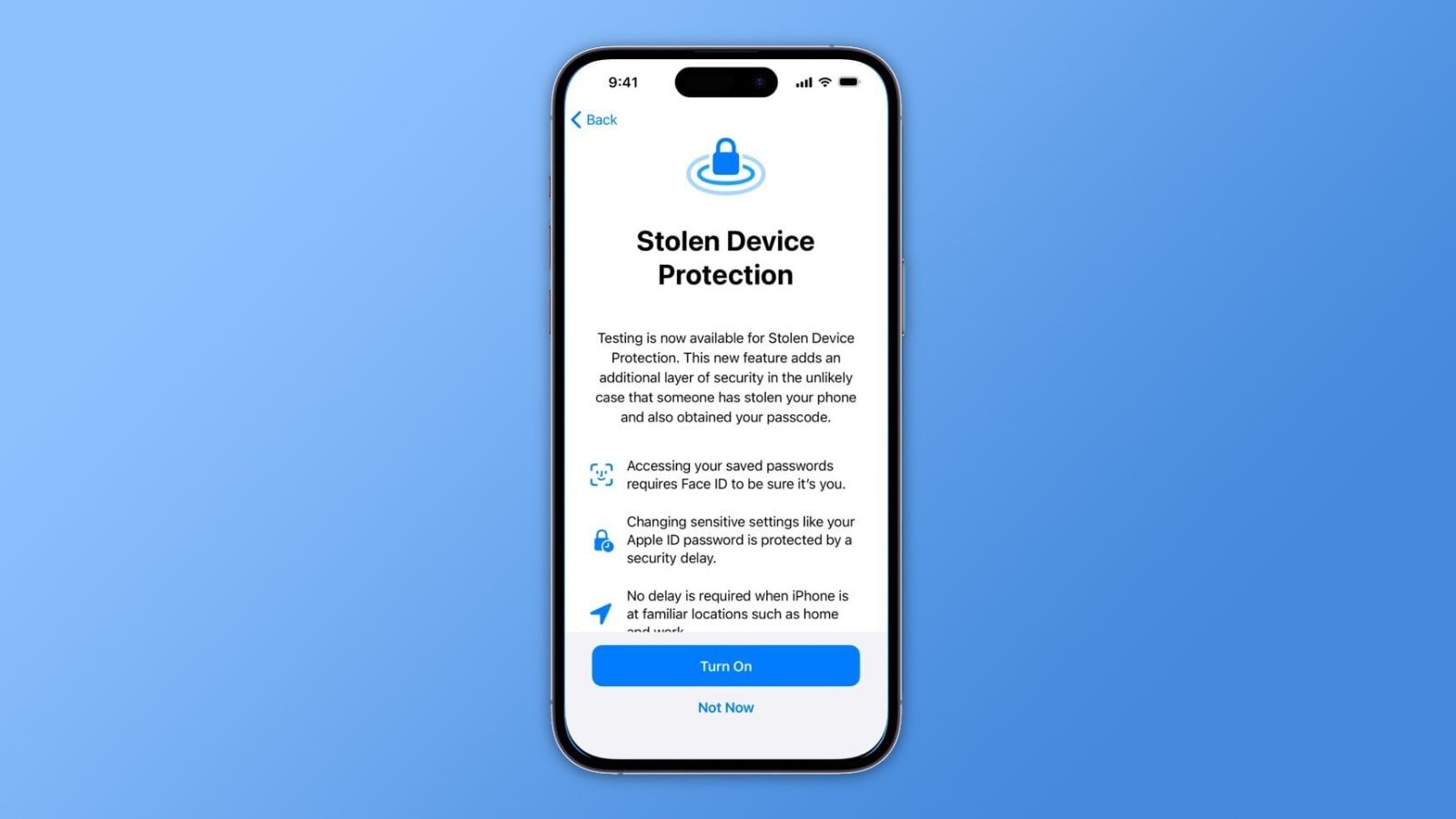

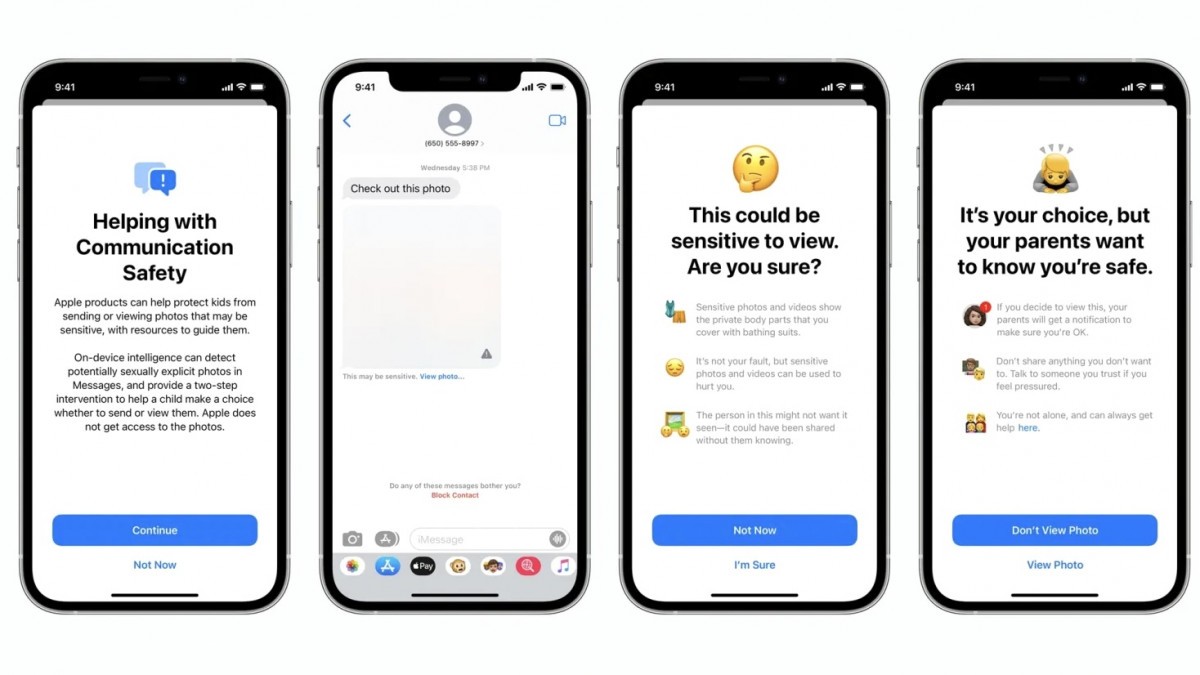

Tout d'abord, une fonctionnalité de sécurité des communications facultative dans l'application Messages sur iPhone, iPad et Mac peut avertir les enfants et leurs parents lorsqu'ils reçoivent ou envoient des photos sexuellement explicites. Lorsque la fonctionnalité est activée, Apple a déclaré que l'application Messages utilisera l'apprentissage automatique sur l'appareil pour analyser les pièces jointes de l'image, et si une photo est jugée sexuellement explicite, la photo sera automatiquement floue.

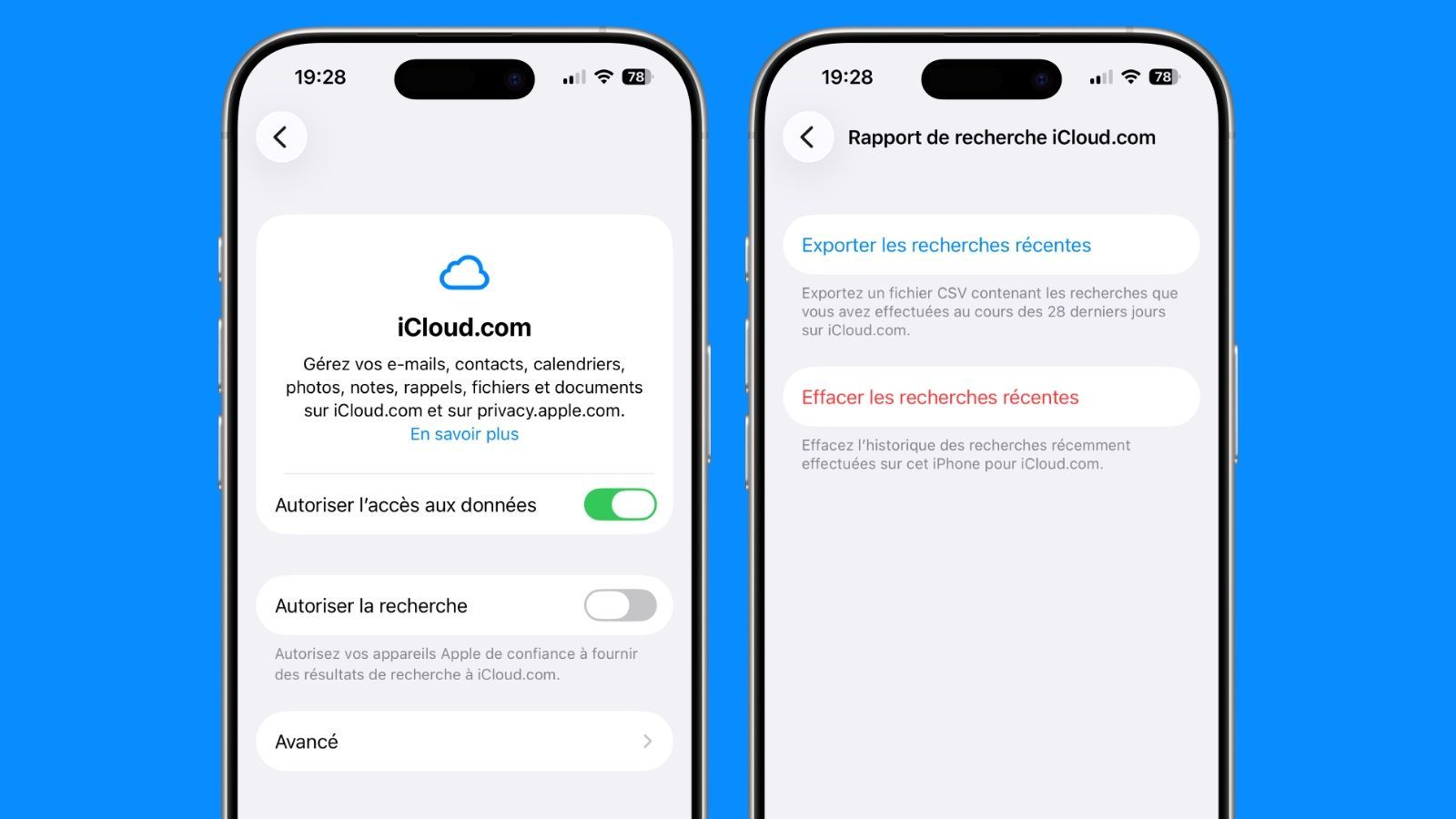

Deuxièmement, Apple sera en mesure de détecter les images connues de Child Sexual Abuse Material (CSAM) stockées dans Photos iCloud, ce qui permettra à Apple de signaler ces cas au National Center for Missing and Exploited Children (NCMEC), une organisation à but non lucratif qui travaille en collaboration avec les organismes d'application de la loi américains. Apple a confirmé aujourd'hui que le processus ne s'appliquera qu'aux photos téléchargées sur Photos iCloud et non aux vidéos.

Troisièmement, Apple élargira les conseils dans Siri et Spotlight Search sur tous les appareils en fournissant des ressources supplémentaires pour aider les enfants et les parents à rester en sécurité en ligne et à obtenir de l'aide dans les situations dangereuses. Par exemple, les utilisateurs qui demandent à Siri comment signaler le CSAM ou l'exploitation des enfants seront dirigés vers des ressources pour savoir où et comment déposer une déclaration.

Ouverture aux app’ications tierces

Apple a déclaré que bien qu'elle n'ait rien à partager aujourd'hui en termes d'annonce, étendre les fonctionnalités de sécurité des enfants à des tiers afin que les utilisateurs soient encore plus largement protégés serait un objectif souhaitable. Apple n'a fourni aucun exemple spécifique, mais une possibilité pourrait être que la fonctionnalité de sécurité des communications soit mise à la disposition d'applications comme Snapchat, Instagram ou WhatsApp afin que les photos sexuellement explicites reçues par un enfant soient floues.

Une autre possibilité est que le système de détection CSAM d'Apple puisse être étendu aux applications tierces qui téléchargent des photos ailleurs qu'iCloud Photos.

Apple n'a pas fourni de délai quant au moment où les fonctionnalités de sécurité des enfants pourraient arriver sous forme de SDK, notant qu'elle doit encore terminer les tests et le déploiement des fonctionnalités, et la société a également déclaré qu'elle devrait s'assurer que toute expansion potentielle ne porterait pas atteinte aux propriétés de confidentialité ou à l'efficacité des fonctionnalités.

De manière générale, Apple a déclaré que l'extension des fonctionnalités à des tiers est l'approche générale de l'entreprise et depuis qu'elle a introduit l'App Store sur iPhone OS 2 en 2008.