Apple développe une méthode révolutionnaire pour l'IA sur iPhone

Alban Martin

Alban Martin- Il y a 2 ans

- 💬 4 coms

- 🔈 Écouter

![]() Le GPT d'Apple est sur le point de se concrétiser. Les chercheurs en intelligence artificielle d'Apple affirment avoir réalisé une percée décisive dans le déploiement de grands modèles de langage (LLM) sur les iPhones et autres appareils Apple dotés d'une mémoire limitée, en inventant une technique innovante d'utilisation de la mémoire flash. Vous allez comprendre pourquoi.

Le GPT d'Apple est sur le point de se concrétiser. Les chercheurs en intelligence artificielle d'Apple affirment avoir réalisé une percée décisive dans le déploiement de grands modèles de langage (LLM) sur les iPhones et autres appareils Apple dotés d'une mémoire limitée, en inventant une technique innovante d'utilisation de la mémoire flash. Vous allez comprendre pourquoi.

Une contrainte de mémoire

Les chatbots et autres services épatants basés sur des LLM, tels que ChatGPT d'OpenAI ou LLaMa de Meta, nécessitent des machines très performantes pour fonctionner. Outre les capacités de calcul, ils sont incroyablement gourmands en mémoire, car ils traitent de quantités de données astronomiques. Même avec un iPhone 15 Pro Max de 1 To, ce n'est pas suffisant pour faire tourner ce genre de logiciel en local. Pour faire en sorte que tout cela tienne dans la poche, sans accès à Internet pour préserver la confidentialité de nos données, les chercheurs d'Apple ont mis au point une nouvelle technique pour exploiter la mémoire flash.

Stockage de l'IA sur la mémoire flash

Dans un nouvel article de recherche intitulé "LLM in a flash : Efficient Large Language Model Inference with Limited Memory", les scientifiques notent que la mémoire flash est plus courante dans les appareils mobiles que la mémoire vive traditionnellement utilisée dans les super-ordinateurs. Leur approche contourne astucieusement cette limitation en utilisant deux techniques clés qui minimisent le transfert de données et maximisent le débit de la mémoire flash :

- Le fenêtrage : Il s'agit d'une méthode de recyclage. Au lieu de charger de nouvelles données à chaque fois, le modèle d'IA réutilise certaines des données qu'il a déjà traitées. Cela réduit le besoin d'aller constamment chercher de la mémoire, ce qui rend le processus plus rapide et plus fluide.

- Regroupement lignes-colonnes : Cette technique revient à lire un livre par morceaux plutôt qu'un mot à la fois. En regroupant les données plus efficacement, elles peuvent être lues plus rapidement à partir de la mémoire flash, ce qui accélère la capacité de l'IA à comprendre et à générer du langage.

Selon l'article, la combinaison de ces méthodes permet aux modèles d'IA de fonctionner jusqu'à deux fois la taille de la mémoire disponible de l'iPhone. Cela se traduit par une augmentation de la vitesse de 4 à 5 fois sur les processeurs standard (CPU) et de 20 à 25 fois sur les processeurs graphiques (GPU). C'est un peu le même principe que la prédiction des calculs au niveau des CPU récents, comme les puces AXX d'Apple, chose qui permet d'aller plus vite dans la majorité des cas (mais qui peut donner lieu à des failles de sécurité).

Cette avancée est particulièrement cruciale pour le déploiement de LLM avancés dans des environnements aux ressources limitées, ce qui élargit leur applicabilité et leur accessibilité.

Une IA plus rapide sur l'iPhone

Cette avancée majeure ouvre de nouvelles possibilités sur iPhone, notamment une version de Siri bien plus efficace. On pourrait ainsi avoir la traduction d'une conversation en temps réel, une amélioration sensible de la photographie ou encore de la réalité augmentée.

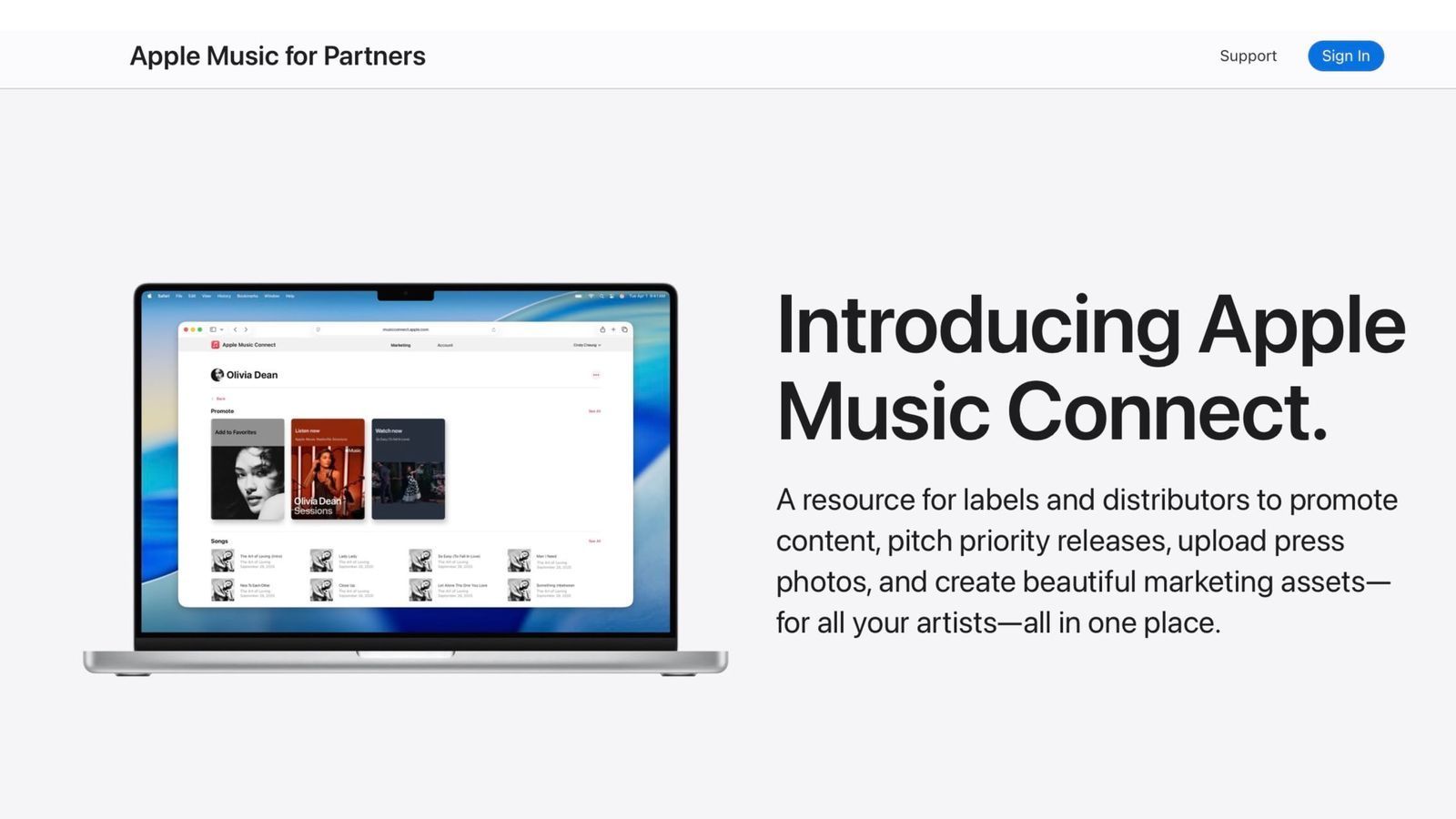

Comme vous le savez probablement, les travaux d'Apple sur l'IA générative pourraient à terme être intégrés à son assistant vocal Siri. En février 2023, Apple a organisé un sommet sur l'IA et a informé ses employés de ses travaux sur les grands modèles de langage. Avec iOS 18, Apple souhaite lancer une version plus intelligente de Siri, profondément intégrée à l'IA. Apple prévoit d'actualiser la façon dont Siri interagit avec l'application Messages, afin de permettre aux utilisateurs de répondre à des questions complexes et de compléter automatiquement des phrases de manière plus efficace. Certaines nouveautés seraient exclusives à l'iPhone 16 Pro.

Apple GPT

Pour tous ces cas d'usage, Apple serait en train de développer son propre modèle d'IA générative appelé "Ajax". Conçu pour rivaliser avec les modèles GPT d'OpenAI, Ajax fonctionne avec 200 milliards de paramètres, ce qui laisse supposer un niveau élevé de complexité et de capacité en matière de compréhension et de génération de langage. Appelé en interne "Apple GPT", ce projet vise à unifier le développement de l'apprentissage automatique au sein d'Apple, ce qui suggère une stratégie plus large visant à intégrer plus profondément l'IA dans l'écosystème du géant américain.

Selon les derniers rapports, Ajax est considéré comme plus performant que la génération précédente ChatGPT 3.5. Toutefois, il serait derrière ChatGPT-4, et encore plus loin de la version Turbo.